인공지능을 활용해 카테터 내부에 날카로운 삼각형 모양의 융기 구조를 설계 융기 구조로 인해 박테리아가 카테터 내부로 이동하지 못해 감염을 예방 대장균에 대한 효과는 입증됐으나, 다른 박테리아 종에 대해서는 추가 연구 필요 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

5의 제곱은 5로 끝난다? 이 패턴을 따르는 숫자를 오토모픽 숫자라고 불러 무한히 큰 수를 제곱하면 마지막 숫자가 …918,212,890,625로 고정돼 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

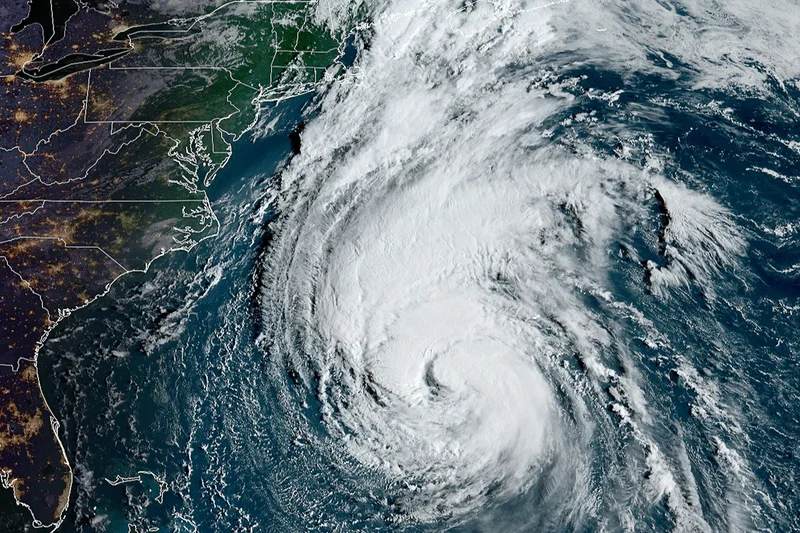

AI 기상 모델 '그래프캐스트', 허리케인 '리'의 상륙을 슈퍼컴퓨터보다 더 빨리 예측해 그래프캐스트는 기존 모델보다 빠르고 저렴하게 예측을 생성할 수 있어 하지만 해석이 어렵고 드문 사건을 예측하는 데는 한계점 분명 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

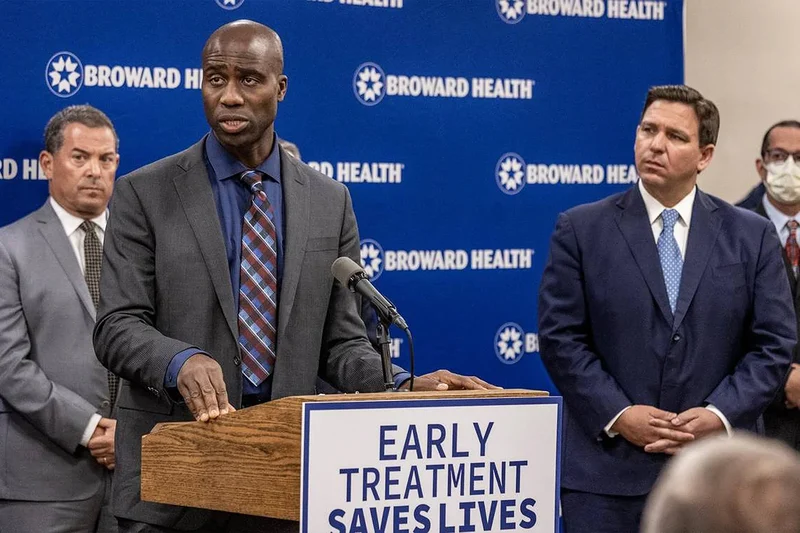

플로리다주 외과의사, 코로나19 백신의 암 유발 가능성 제기 FDA 및 전문가들은 "근거 없고, 백신 접종의 이점 훨씬 커" 백신 접종 부작용도 있지만 손실 회피 편향에 빠지면 안 돼 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

잠정 합의안 따르면 대부분의 오픈소스 AI 모델은 면제 위험도가 높은 범용·기반 모델은 규제 대상에 포함 깃허브 등 오픈소스 생태계 주체, 지속가능성 위한 노력 지속해야 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

작년 9월 2일 발사된 아디티아-L1, 라그랑주 1지점에 곧 도착 예정 궤도 안정성 및 적은 연료 사용으로 태양 관측에 이상적인 L1 라그랑주점 간의 중력 시너지를 파악해 비행 효율성이 더 높아질 전망 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 콘텐츠 제휴가 진행 중입니다.

Read More

캡 세트 문제의 새로운 하한선 제시한 딥마인드의 LLM 펀서치, 수학 함수 생성기 위에 판단·개선용 LLM을 쌓은 다층 구조 인공지능의 가능성 넓혀, 수학자의 창의성 자극하는 '촉매제' [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

Read More

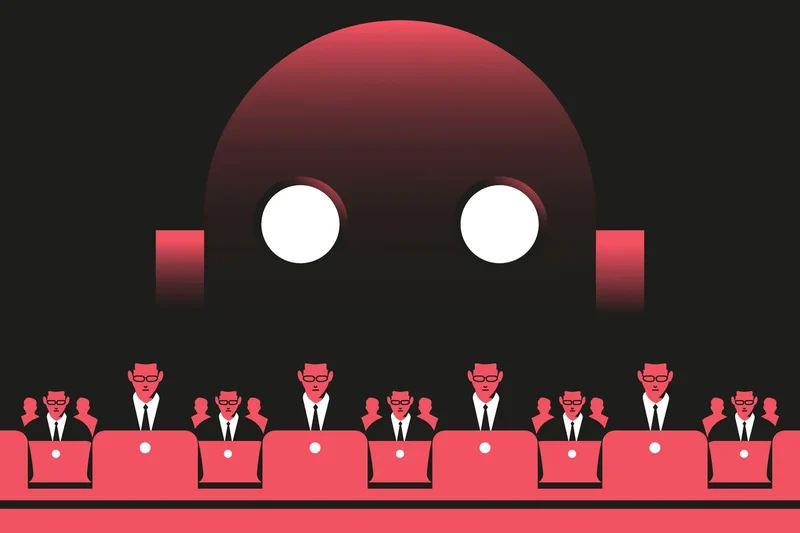

검색엔진은 사람들의 믿음을 바꿀 수 있으며, 특히 검색 정보가 부족한 상황에서 더 쉽게 믿어 구글 등 기술회사는 잘못된 정보 유포를 막으려 노력하지만 한계가 있어 정확한 정보 검색 방법 교육, 다양한 이해관계자 협력 등 종합적인 해결책이 필요해 [해외DS] 검색엔진, 가짜뉴스에 대한 믿음 증폭시켜 (1)에서 이어집니다.

Read More

검색엔진 사용으로 거짓 정보 믿을 확률 20% 증가 검색어에 따라 거짓 정보 노출 빈도 달라져 데이터 리터러시가 핵심, 검색 능력 제고 필요 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

Read More

물 부족은 다른 결핍과 달리 사람들의 사고방식을 미래 지향적으로 만들어 전 세계적으로 동일한 현상이며 나라 간의 문화 차이도 설명해 인간은 물에 의존적이며 진화 과정에서 물 부족에 민감해졌을 가능성 있어 [해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 저희 데이터 사이언스 경영 연구소 (GIAI R&D Korea)에서 영어 원문 공개 조건으로 콘텐츠 제휴가 진행 중입니다.

Read MorePagination

- First page

- Previous page

- …

- 8

- 9

- 10

- …

- Next page

- Last page