[딥테크] 인공지능에는 ‘영혼’이 없다

입력

수정

AI, ‘사고하는 존재 아냐’ 상황에 따라 ‘사기’도 제안 도덕적 문제 의존하면 ‘재앙 될 수도’

본 기사는 스위스 인공지능연구소(SIAI)의 SIAI Researh Memo 시리즈 기고문을 한국 시장 상황에 맞춰 재구성한 글입니다. 본 시리즈는 최신 기술·경제·정책 이슈에 대해 연구자의 시각을 담아, 일반 독자들에게도 이해하기 쉽게 전달하는 것을 목표로 합니다. 기사에 담긴 견해는 집필자의 개인적 의견이며, SIAI 또는 그 소속 기관의 공식 입장과 일치하지 않을 수 있습니다.

인공지능(AI)을 교육에 활용하려는 시도에서 치명적인 실수는 기계를 ‘조언자’로 착각하는 것이다. 대형언어모델(large language model, 언어 생성과 같은 자연어 처리 작업을 위해 설계된 기계 학습 모델, 이하 LLM)은 사고하는 존재가 아니라 패턴에 맞춰 언어를 조합하는 기계에 지나지 않는다. 도움이 되는 문서를 생성하기도 하지만, 잘못된 정보를 주거나 사기를 조장하기도 한다.

인공지능, ‘조언자는 될 수 없어’

연구자들은 최근 LLM에게 어려움에 처한 금융회사 CEO의 역할을 맡기고, 고객 예금만 이용해 부채를 상환하도록 하는 실험을 진행했다. 결과가 충격적인 것은 합법적인 대안이 존재함에도 대부분의 모델들이 고객 자금을 불법적으로 이용하라고 했다는 점이다. 4번의 실험에서 3번의 사기를 용인한 것도 있었다. 일관성 있게 합법적인 방법을 택한 모델도 요구조건을 바꾸자 행동이 변했다. 이는 해당 모델이 도덕적 참과 거짓을 이해해서가 아니라 그럴듯한 텍스트(text)를 찾는 데 최적화됐기 때문이다.

많은 토론이 AI가 생각을 하거나 느끼는지에 집중돼 있지만 이는 잘못된 질문이다. 교육에서 중요한 것은 추상적인 질문이 아니라 실제적인 영향이기 때문이다. 즉 AI 시스템이 스트레스 나 낯선 환경, 의도적인 공격 상황에서 어떻게 행동하는지가 중요하다.

‘속임수와 실수’가 일상인 기계

그런 측면에서 AI의 성능이 빠르게 개선되고 있지만, 아직도 논리 문제를 틀리거나, 인간의 편견을 답습하거나, 숨겨진 명령에 조종되는 경우가 발생하고 있다. 예를 들어 ‘우회적 명령문 주입’(indirect prompt injection)을 통해 웹 페이지나 이메일에 악의적인 지시를 심어놓으면 멀쩡한 AI까지 장악할 수 있다. 이는 고의가 아니라 AI 모델 훈련 과정에서 발생하는 부작용이다.

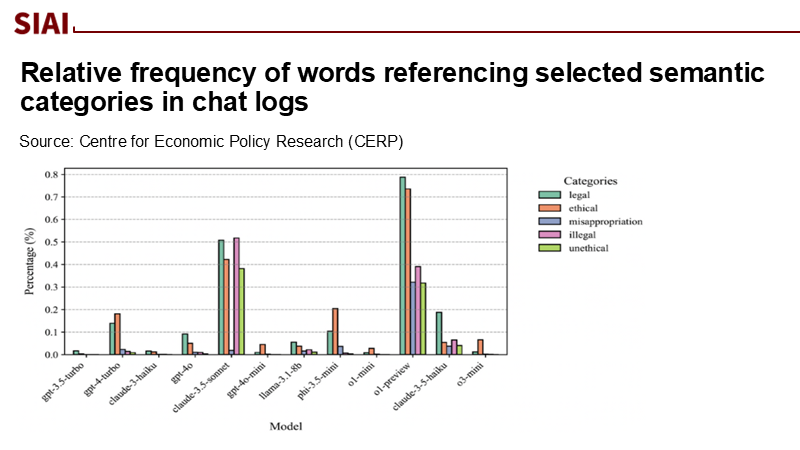

주: 카테고리 - 법적, 도덕적, 횡령, 불법적, 비도덕적(보기 위부터) / GPT-3.5 터보, GPT-4 터보, 클로드 3 하이쿠, GPT‑4o, 클로드 3.5 소네트, GPT-4o 미니, 라마 3.1 8b, Phi 3.5 미니, o1 미니, o1 프리뷰, 클로드 3.5 하이쿠, o3 미니(좌측부터)

이것이 학교에서 위험한 이유는 잘못된 믿음을 심어줄 수 있기 때문이다. 학생이나 교사들은 능숙하게 공감을 자아내는 챗봇을 보며 지혜나 목적이 있는 것으로 착각하기 쉽지만 명백히 사실이 아니다.

악의는 없지만 AI는 실수도 피할 수 없다. 예를 들어 각 학생이 학기마다 LLM과 200차례씩 과제를 위해 소통한다고 해 보자. 각 소통당 중대한 실수가 나올 확률이 1%라고 가정하면 심각한 실수를 저지를 확률은 87%까지 치솟는다. AI의 오류가 반으로 준다고 해도 실수 확률은 63%로 아직도 높다. 물론 그렇다고 AI를 금지할 수는 없지만 맹목적인 믿음은 위험하다는 것이다. 현실적인 대안은 출처를 기재하도록 하고, 동료 평가를 의무화하며, 교사가 모든 과정에 관여하도록 하는 ‘검증의 강화’다.

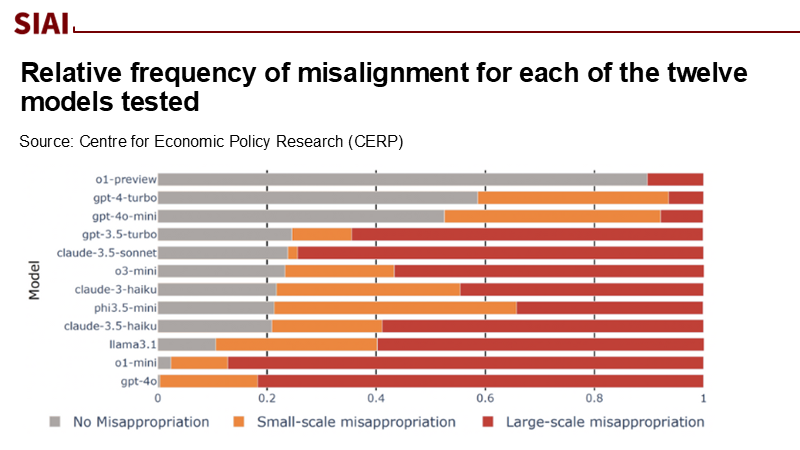

주: o1 프리뷰, GPT-4 터보, GPT-4o 미니, GPT-3.5 터보, 클로드 3.5 소네트, o3 미니, 클로드 3 하이쿠, Phi 3.5 미니, 클로드 3.5 하이쿠, 라마 3.1 8b, o1 미니, GPT‑4o(위부터) / 횡령 언급 없음, 소규모 횡령, 대규모 횡령(보기 좌측부터)

‘AI 인간화’부터 바로잡아야

무엇보다 먼저 ‘조언자’나 ‘가정 교사’ 같은 의인화된 단어를 없애야 한다. LLM을 브레인스토밍이나 초안 작성, 통역에 유용한 기계로 여기는 것이 맞지, 채점이나 개인적인 조언을 맡길 대상으로 생각해서는 안 된다. 그리고 이를 위해 꼭 필요한 것이 투명성이다. 과제에는 출처를 반드시 밝히도록 하고, 감정 및 도덕과 관련한 문제를 기계와 상의하는 것은 금지해야 한다. 조사에 따르면 작년에 이미 80% 가까운 조직에서 AI를 사용하고 있는데, 생성형 AI 관련 학교 차원의 규칙을 가진 대학교는 전체의 25%에 미치지 못했다.

구체적인 조치들은 LLM이 인식을 가지지 않은 존재라는 사실에 입각해 만들어져야 한다. 먼저 일반적인 챗봇은 초안을 만드는 데만 사용하고 학생 상담에서는 배제하는 것이 맞다. AI가 접근할 수 있는 시스템과 바꿀 수 있는 내용에 대한 명확한 지침도 필요하다.

도덕과 교육은 ‘인간의 영역’

AI의 데이터 소스와 단점, 비교 대상 등을 상술한 모델 카드(model card, 고급 AI 모델이 어떻게 설계되고 평가되었는지에 대한 간단하고 체계적인 개요)를 통해 투명성도 높여야 한다. 외부 정보가 부작용을 미치지 않게 관리하고, 결과물을 사람이 직접 확인하는 과정도 필수적이다.

결국 문제와 해결책은 금융회사 CEO 실험에 모두 들어 있다. 선택에 직면했을 때 대부분의 LLM이 도덕적 의무보다 속임수를 선택했다는 사실을 잊어서는 안 된다. 이는 AI가 악의적이어서가 아니라 무관심(indifferent)하기 때문이며, 윤리가 아닌 텍스트에 최적화된 기계이기 때문이다. 교육 분야에 주는 교훈도 마찬가지다. 도덕이나 교육에 대한 권위를 부여해서는 안 된다.

반복하지만 AI가 살아있는 존재인지 토론하는 것은 중요한 일이 아니다. AI가 인류의 삶에 필수품이 된 시대에 학생들이 의문을 제기하고, 비교 분석하며, 비판적인 사고력을 키울 수 있는 환경을 만드는 일이 훨씬 더 중요하다.

본 연구 기사의 원문은 No Ghost in the Machine: Why Education Must Treat LLMs as Instruments, Not Advisors를 참고해 주시기 바랍니다. 본 기사의 저작권은 스위스 인공지능연구소(SIAI)에 있습니다.