[딥테크] 인공지능 전력 수요, ‘해답 보인다’

입력

수정

AI 데이터센터 전력 수요, ‘천문학적’ 작업 단위당 에너지 사용도 ‘빠르게 줄어’ 사용량 증가 및 전력량 감소 ‘동시 가능’

본 기사는 스위스 인공지능연구소(SIAI)의 SIAI Researh Memo 시리즈 기고문을 한국 시장 상황에 맞춰 재구성한 글입니다. 본 시리즈는 최신 기술·경제·정책 이슈에 대해 연구자의 시각을 담아, 일반 독자들에게도 이해하기 쉽게 전달하는 것을 목표로 합니다. 기사에 담긴 견해는 집필자의 개인적 의견이며, SIAI 또는 그 소속 기관의 공식 입장과 일치하지 않을 수 있습니다.

에너지 측면에서 보면 인공지능(AI)은 기회와 위험을 동시에 제기한다. 미국과 중국, 유럽을 중심으로 데이터센터에 필요한 전력 수요가 폭발적으로 증가하고 있지만, 단위당 AI 작업에 드는 에너지도 빠르게 줄고 있기 때문이다. 그렇다면 이제 전체 전력량 지표 외에 토큰(token, AI 모델에서 처리되는 단어의 단위)당 소비 전력량도 눈여겨봐야 할 것 같다.

작업당 전력량 ‘급감’

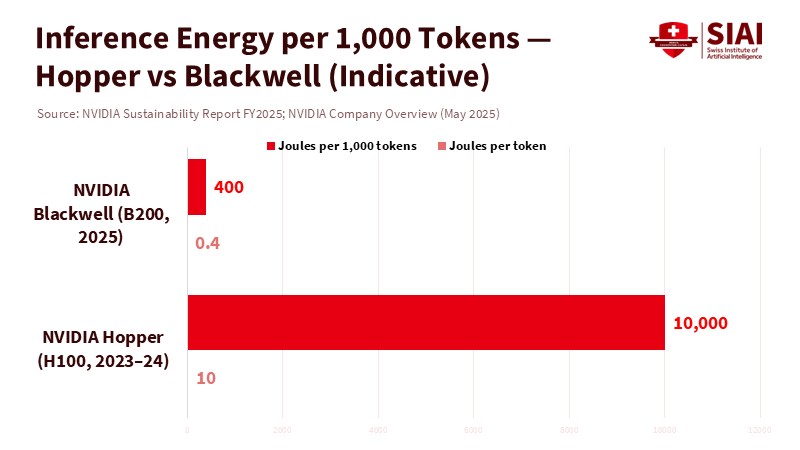

엔비디아는 최근 출시한 칩(chip)으로 첨단 AI 모델을 돌리는 데 필요한 전력이 토큰당 0.4줄(joules)로 줄어 10년 전에 비해 에너지 효율이 십만 배 향상됐다고 밝혔다. 전체 전력량은 증가하고 있지만 효율성 향상 속도가 이 정도라면 이야기가 달라진다. 특히 클라우드 플랫폼과 학내 컴퓨팅에 의존하는 교육 기관들은 전력 사용에 대한 지나친 우려에서 벗어날 수 있을 것으로 보인다. 에너지 비용과 탄소 배출량을 줄이는 동시에 AI 활용을 통한 교육 효과도 극대화할 수 있다.

2030년까지 데이터센터 전력 수요는 미국이 240테라와트시(TWh), 중국이 175테라와트시에 이르고, 유럽도 45테라와트시를 사용할 것으로 전망된다. 하지만 해당 수치는 얼마나 빠르게 기술 수준이 높아지고, 효율성이 전파되는지에 따라 크게 바뀔 수 있다.

최첨단 ‘모델’ 및 ‘그래픽 처리 장치’ 등장

이미 ‘에너지 절약형 AI 모델’(mixture-of-experts architectures )을 통해 매개변수(model parameter)의 일부만 활용하면서 작업을 수행할 수 있다. 또 추론 최적화 기법(speculative decoding, 소수의 토큰을 작성한 후 모든 토큰을 병렬로 검증)과 양자화(quantization, 메모리와 컴퓨팅이 덜 필요한 더 작고 효율적인 모델을 만들어 실행) 기술로 작업 수준을 훼손하지 않으면서 에너지 소모를 줄일 수 있다.

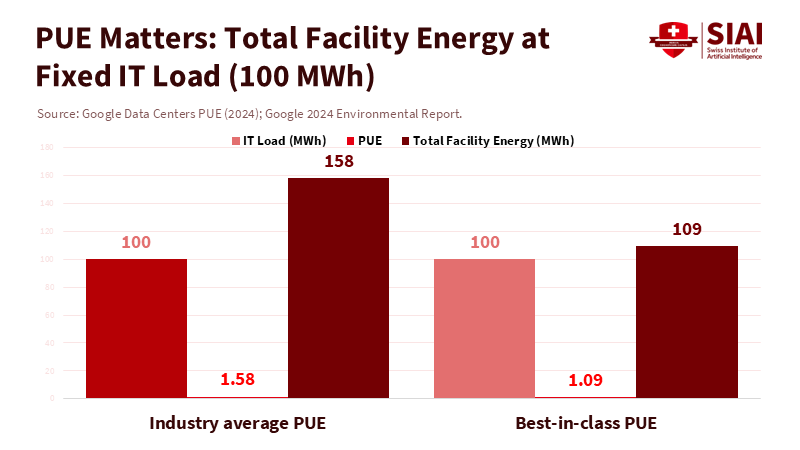

하드웨어도 마찬가지다. 블랙웰(Blackwell, 엔비디아의 최신 그래픽 처리 장치) 수준의 AI 가속기(accelerator)는 훨씬 낮은 전력량으로 더 많은 작업을 소화할 수 있고, 클라우드 업체들도 전력 사용 효율성(Power Usage Effectiveness, PUE)을 1.1까지 낮췄다. 이제 대부분의 에너지가 시스템 냉각이 아닌 칩과 메모리에 투입된다는 얘기다.

주: 엔비디아 블랙웰(상단), 엔비디아 호퍼(하단)

주: 업체 평균(좌측), 동급 최고 수준(우측), *막대그래프 사이의 숫자는 전력 사용 효율성

학교, 비용 부담 줄고 효율성은 향상

클라우드 요금 및 장비 업그레이드를 포함해 늘어나는 AI 비용에 시달리는 교육 기관들에는 반가운 소식이 아닐 수 없다. 이제 AI 용량이 아니라 교육 효과에 맞는 에너지를 구매하는 것으로 개념 자체가 바뀌었기 때문이다. AI 공급업체는 모델 사양만이 아니라 라우팅(routing, 네트워크상에서 최선의 경로를 선택하는 과정) 및 토큰당 에너지 소비량을 공개해야 하는 상황이 됐다. 예를 들어 하루에 AI 작업을 위해 백만 토큰을 사용하는데, 필요 전력량이 토큰당 5줄에서 0.5줄로 감소하면 일일 에너지 감축량이 4.5메가와트시(MWh)에 이른다. 흐름대로라면 시간이 갈수록 재정적인 부담과 탄소 배출량이 줄어들 것이다.

작업 관리 방식의 개선도 에너지 효율에 이바지한다. 교육 분야에서 생성형 AI는 비동기 방식(asynchronously) 사용이 증가하고 있는데, 이는 일괄 채점과 데이터세트 정리와 같은 작업을 혼잡이 적은 시간대로 옮길 수 있음을 의미한다. 증강 검색 기능(retrieval-augmented generation, 정보 검색 시스템과 결합)도 토큰 사용 수를 줄일 수 있고, 캐싱(caching, 원본 대신 고속 데이터 복사본을 사용)도 지시문의 중복 사용을 억제해 준다.

학습 효과 극대화와 전력량 감소 ‘동시에 가능’

단위당 전력 수요가 줄면 그만큼 이용량이 늘어날 것이라는 의견이 있는데, 이를 막기 위해서는 학생 1인당 토큰 수를 제한하고, 라우팅 규칙을 도입해 AI 사용을 ‘출력물 대기’처럼 관리할 필요가 있다. 에너지 효율 향상 자체를 의심하는 목소리도 있지만 단위당 에너지 효율이 획기적으로 개선되는 것은 명백한 사실이다. 효율성 향상을 부추기고 불투명한 관행을 막을 수 있는 정책 도입만 있으면 된다.

지금까지의 사실로 볼 때 교육 분야는 천문학적 에너지 수요에 발목 잡히지 않고 AI 활용을 확대할 수 있을 것으로 전망된다. 학교들이 학생 1인당 에너지 비용과 탄소 배출량을 줄이면서 AI 사용량을 늘려 나간다면 글로벌 전력 수요 증가세도 완화할 수 있다. 데이터센터는 토큰당 1줄 이하의 전력으로 작업을 수행할 수 있고, 소규모 모델로 더 큰 작업이 가능하며, 절약형 AI 모델로 효과를 극대화할 수 있다.

남은 것은 관련 계약과 지표, 운영 규칙을 포괄하는 정책 도입이다. 앞서 언급했듯이 교육 기관들에는 전체 전력 수요보다 학습 효과 대비 에너지 비용이 더 중요해졌다. 신중하게 판단한다면 AI 사용을 늘리면서 해당 비용을 낮추는 것이 불가능해 보이지 않는다.

본 연구 기사의 원문은 AI Energy Efficiency in Education: The Policy Lever to Bend the Power Curve를 참고해 주시기 바랍니다. 본 기사의 저작권은 스위스 인공지능연구소(SIAI)에 있습니다.