Class 7. Artificial Neural Network

Input

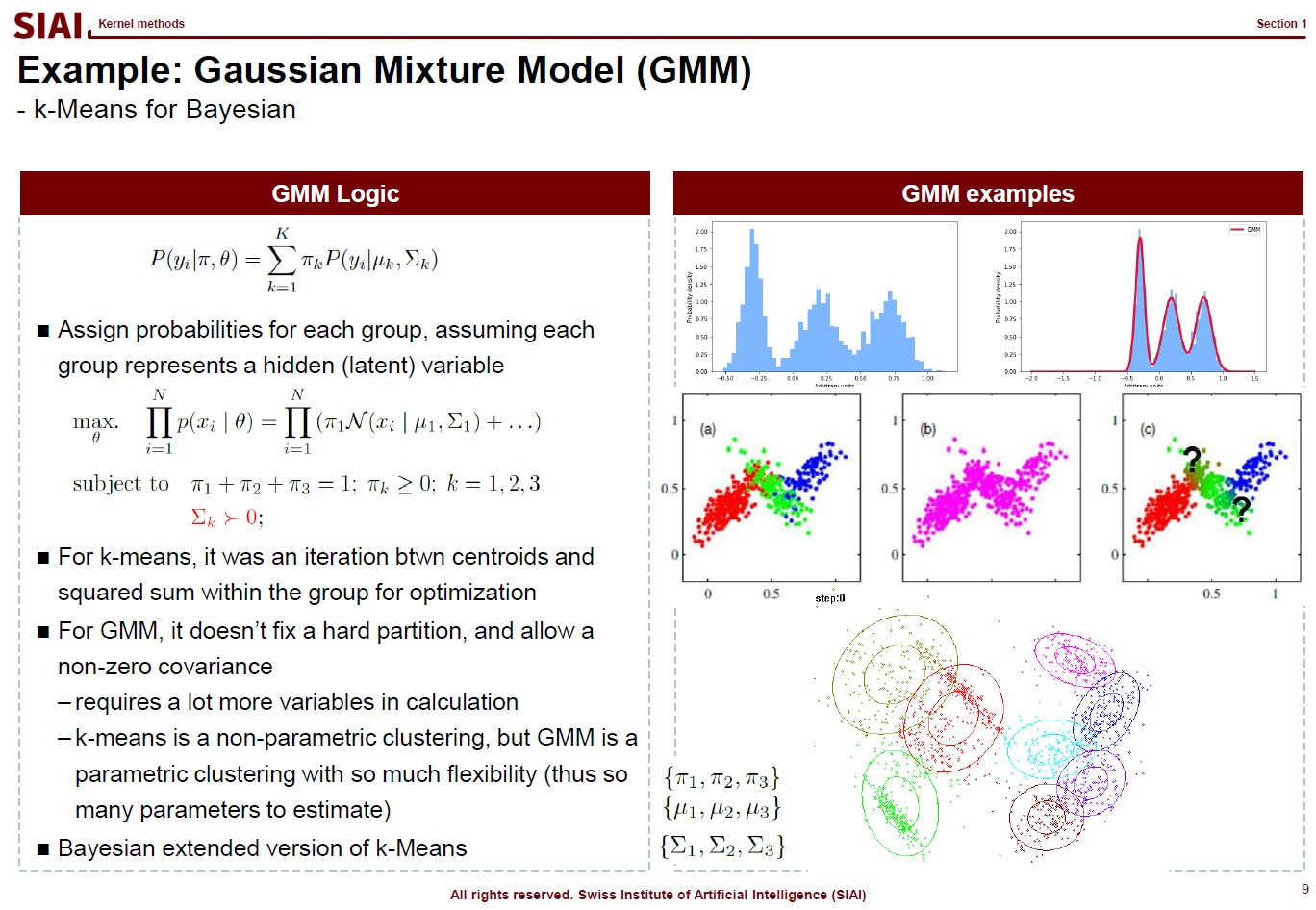

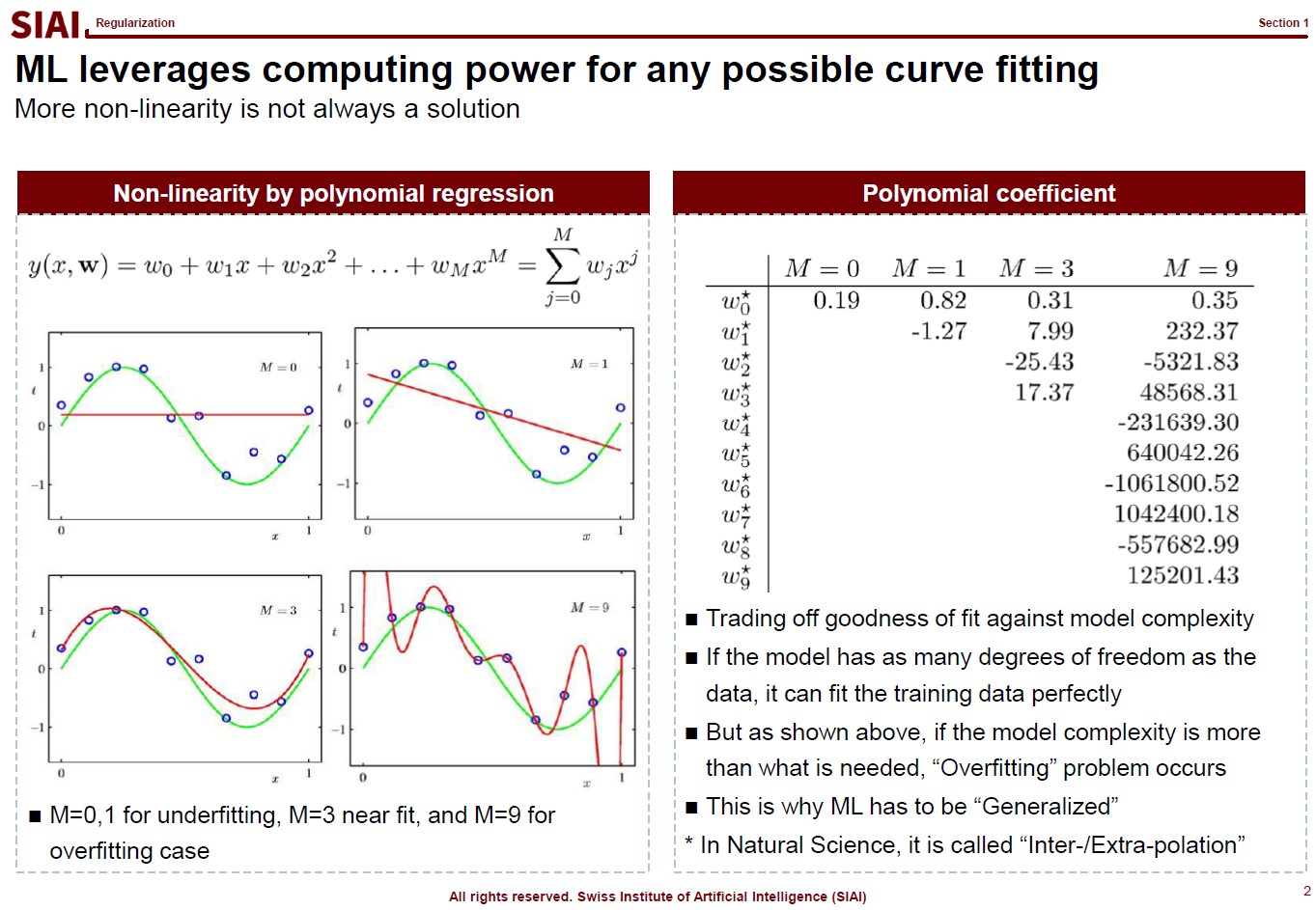

In computational science, curve fitting falls into the category of non-linear approximation. Unlilke what we have discussed in Class 1. Regression, the functional shape now has one of the two following shapes.

Just to make the illustration simple, let's think about simpler format, linear format. For the 3rd order function w.r.t. $x$, you need 4 parameters to be defined, which are $w_0$, $w_1$, $w_2$, and $w_3$. High school math helps us to find the values, as long as we have 4 points of the function. You need the 4th point for $w_0$, or anchor value. Then, what if the linear representation of a curve requires more than the 3rd of $x$? What if it requires 10th order of $x$? For $n$th order, we know from high school that we need at least $n+1$ points to fit the function. What if the function has infinite ups and downs? How many points do you need?

This is where we need to be smarter than high school. We need to find a pattern of the function so that we don't have to go all the way upto $\infty$th order. This can be done if the function does have a pattern. If not, we might have to sacrifice the quality of the fit, meaning we do not aim for 100% fit.

Machine Learning is a topic that helps us to do above task, a lot more scientifically than simple trial and error.

Assume that there are 10 points on the space. Except the case where 10 points are generated by a simple function (like $y=x$ or $y=x^2$), it is unlikely that we are going to end up with the perfect fit, unless we use all 10 points. The simplest linear form of the function will have 9th order of $x$ for 10 coefficients.

Let's say you do not want to waste your time and effort for upto 9th order. It is too time consuming. You just want the 3rd order, or 4 coefficients. It will be much faster and less painful to do the calculation, but your function is unlikely going to be perfect fit. The less order you add to the function, the less accuracy you can achieve.

One may argue that it is computer that does all the calculation, then why worry about time/effort? Imagin you have to fit a function that has 1 trillion points. As the data set becomes larger, unless you have a pattern w/ lower order representation or you give up accuracy, you are going to pay large amount of computational cost. More details have already been discussed in COM501: Scientific Programming.

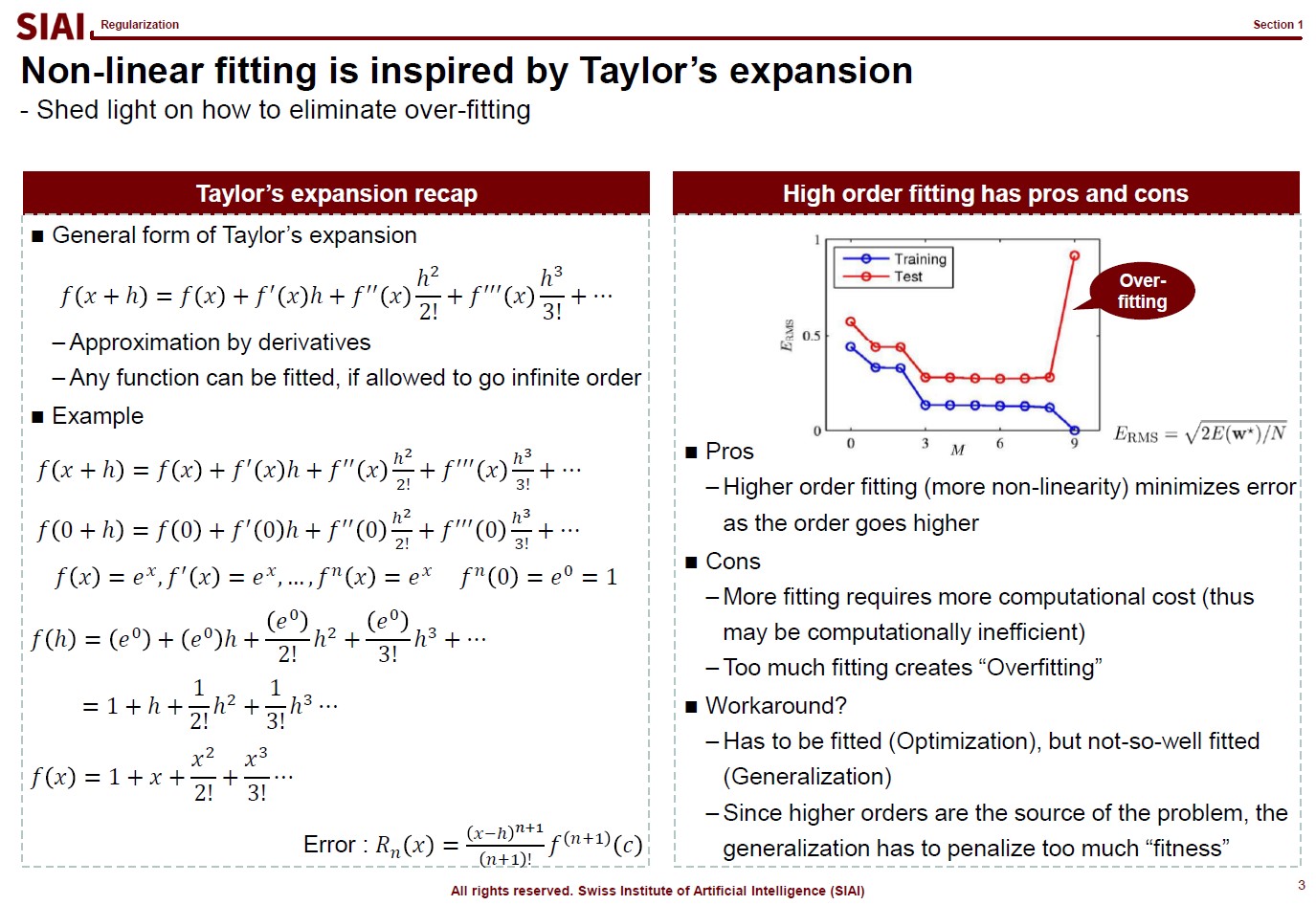

Before going deeper, let me emphasize one mathematical concept. The linear form for a curve fit is, in fact, no different from Taylor's expansion from elementary linear algebra, at least mathematically. We often stop at 1st or 2nd order when we try to find an approximation, precisely the same reason that we do not want to waste too much computational cost for the 1 trillion points case.

And for the patterned cases like $y=sin(x)$ or $y=cos(x)$, we already know the linear form is a simple sequence. For those cases, it is not needed to have 1 trillion points for approximation. We can find the perfect fit with a concise functional form.

In other words, what machine learning does is nothing more than finding a function like $y=sin(x)$ when your data has infinite number of ups and downs in shape.

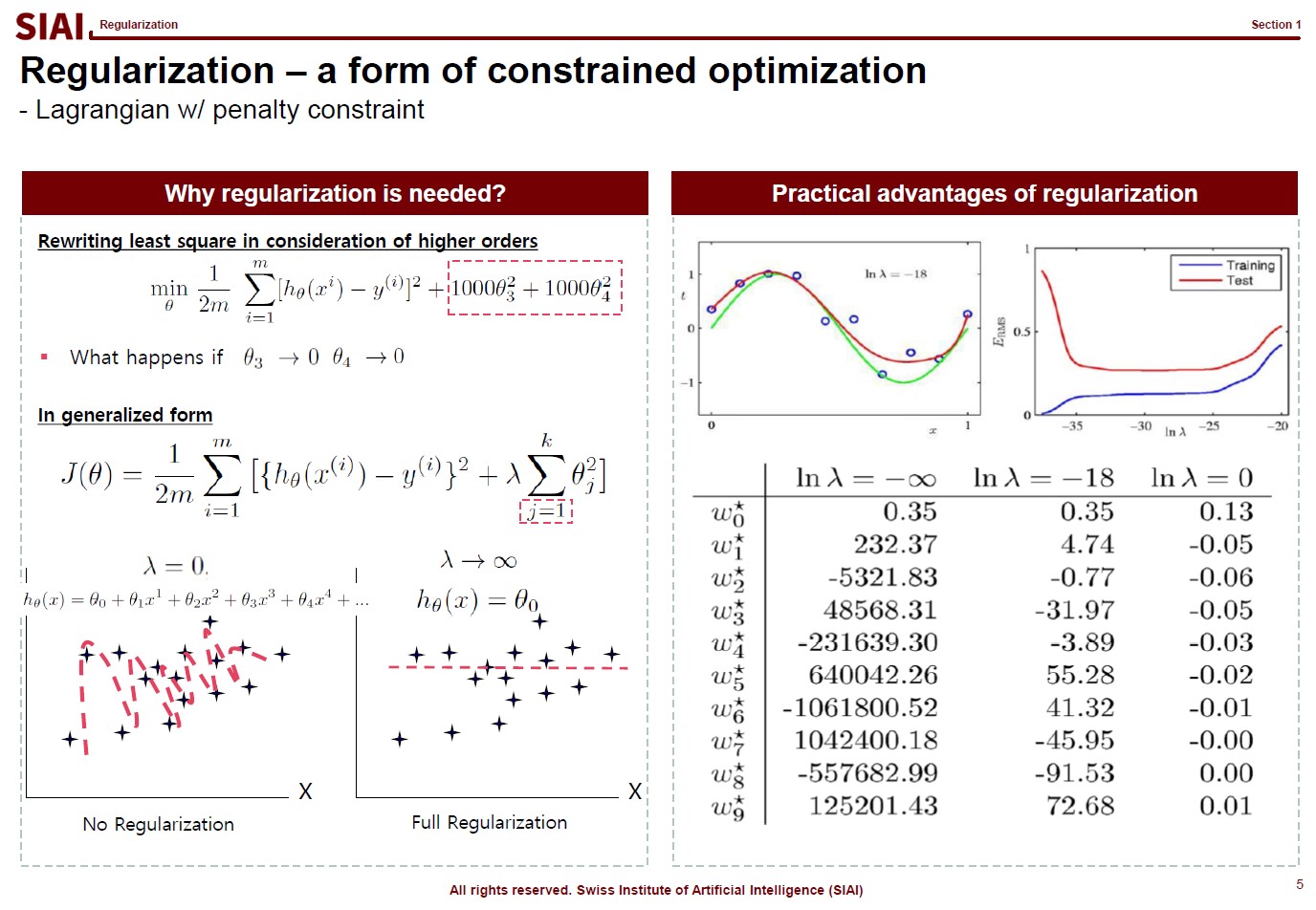

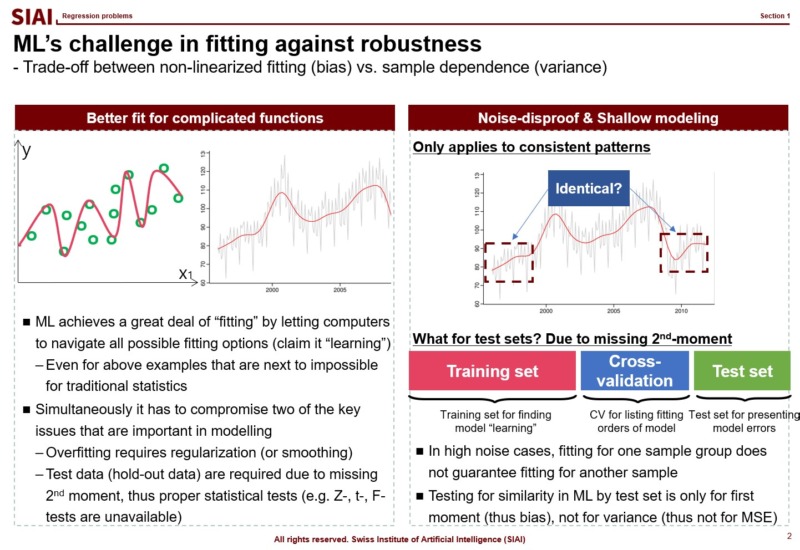

Let's think about regularization. ML textbooks say that regularization is required to fit the function more generally while sacrificing the perfect fit for a small sample data.

Borrowing more mathematical terms, we can say that the fitting is to find the maximum optimization. ML can help us to achieve better fit or more optimization, if linear approximation is not perfect enough. This is why you often hear that ML provides better fit than traditional stat (from amateur data scientists, obviously).

But, if the fit is limited to current sample data set only, you do not want to claim a victory. It is better to give up some optimization for better generality. The process of regularization, thus is generalization. What it does is to make the coefficients smaller in absolute value, thus make the function less sensitive to data. If you go full regularization, the function will have (near) 0 values in all coefficients, which will give you a flat line. You do not want that, after spending heavy computational cost, so the regularization process is to build a compromise between optimization and generalization.

(Note that, in the above screenshot, j starts from 1 instead of 0 ($j=1$), because $j=0$ is the level, or anchor. If you regularize the level, your function converges to $y=0$. Another component to help you to understand that regularization is just to make the coefficients smaller in absolute value.)

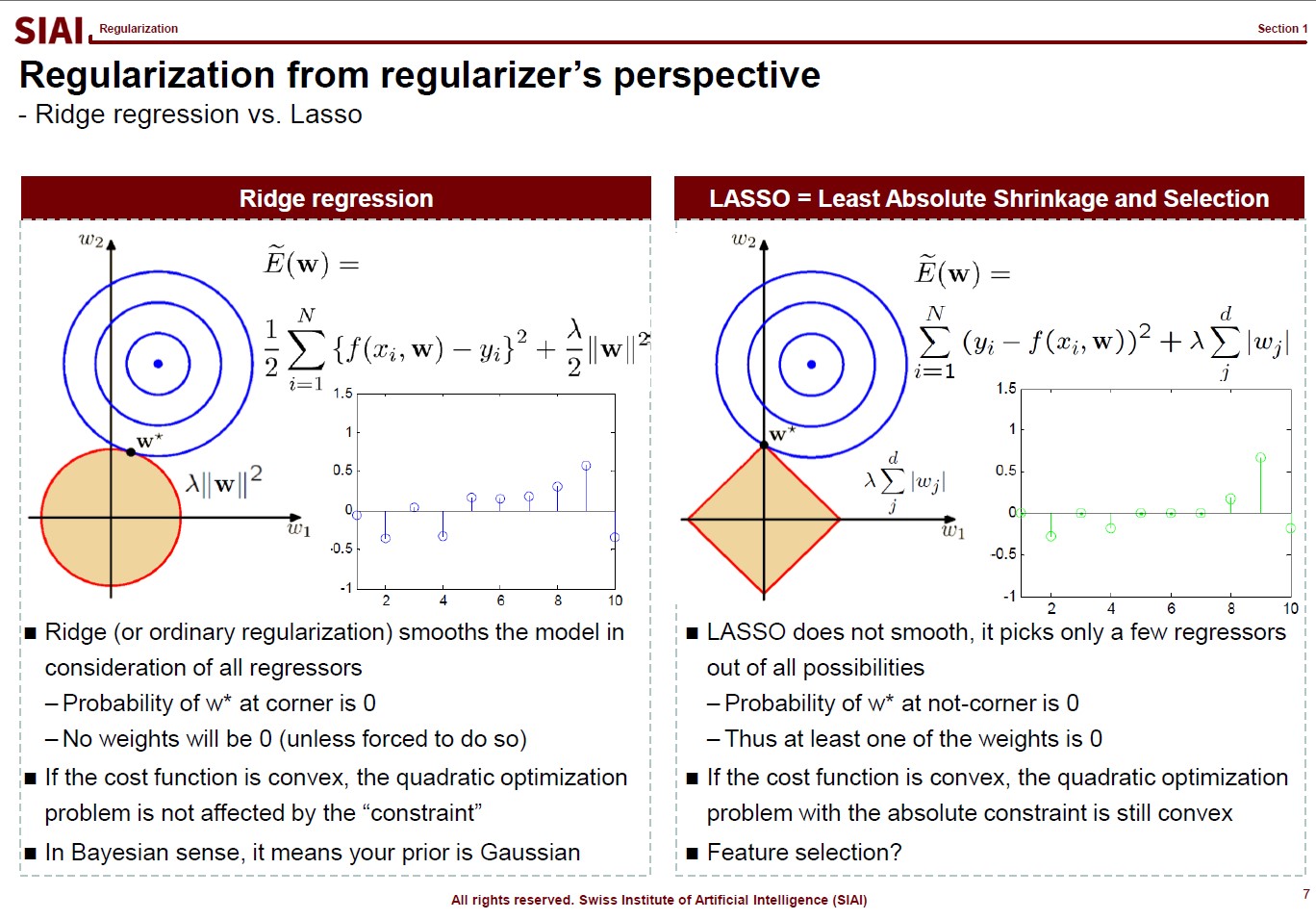

There are, in fact, many variations that you can create in regularization, depending on your purpose. For example, students ask me why we have to stick to quadratic format ($\theta^2$), instead of absolute value ($|\theta|$). Both cases are feasible, but for the different purposes.

In the above lecture note, the quadratic case is coined as 'Ridge' and the absolute as 'LASSO'. The quadratic case is to find a combination of $\theta_1$ and $\theta_2$, assuming it is a 2-dimensional case. Your regularization parameter ($\lambda$) will affect both $\theta_1$ and $\theta_2$. In the graphe, $w*$ has non-zero values of ($w_1$, $w_2$).

On the contrary, LASSO cases help you to isolate a single $\theta$. You choose to regularize either from $x_1$ or $x_2$, thus one of the $\theta_i$ will be 0. In the graph, as you see, $w_1 is 0.

By the math terms, we call quadratic case as L2 regularization and the absolute value case as the L1 regularization. L1 and L2 being the order of the term, in case you wonder where the name comes from.

Now assume that you change the value of $\lambda$ and $w_i$. For Ridge, there is a chance that your $w=(w_1, w_2)$ will be (0,$k$) (for $k$ being non zero), but we know that a point on a line (or a curve) carries a probability of $\frac{1}{\infty}$. In other words, for Ridge, the chance that you will end up with a single value regularization is virtually 0. It will affect jointly. But LASSO gives the opposite. From $w=(0, w_2)$, an $\epsilon$(>0) change of your parameter will take you to $w=(w_1, 0)$. Again, the probability of non-zero $w_i$s is not 0, but your regularization will not end up with that joint point.

Obviously, your real-life example may invalidate above construction in case you have missing values, your regularizers have peculiar shapes, or any other extensions. I added this slide because I've seen a number of amateurs simply test Ridge and LASSO and choose whatever the highest fit they end up with. Given the purpose of regularization, higher fit is no longer the selection criteria. By the math, you can see how both approaches work, so that you can explain why Ridge behaves in one way while LASSO behaves another.

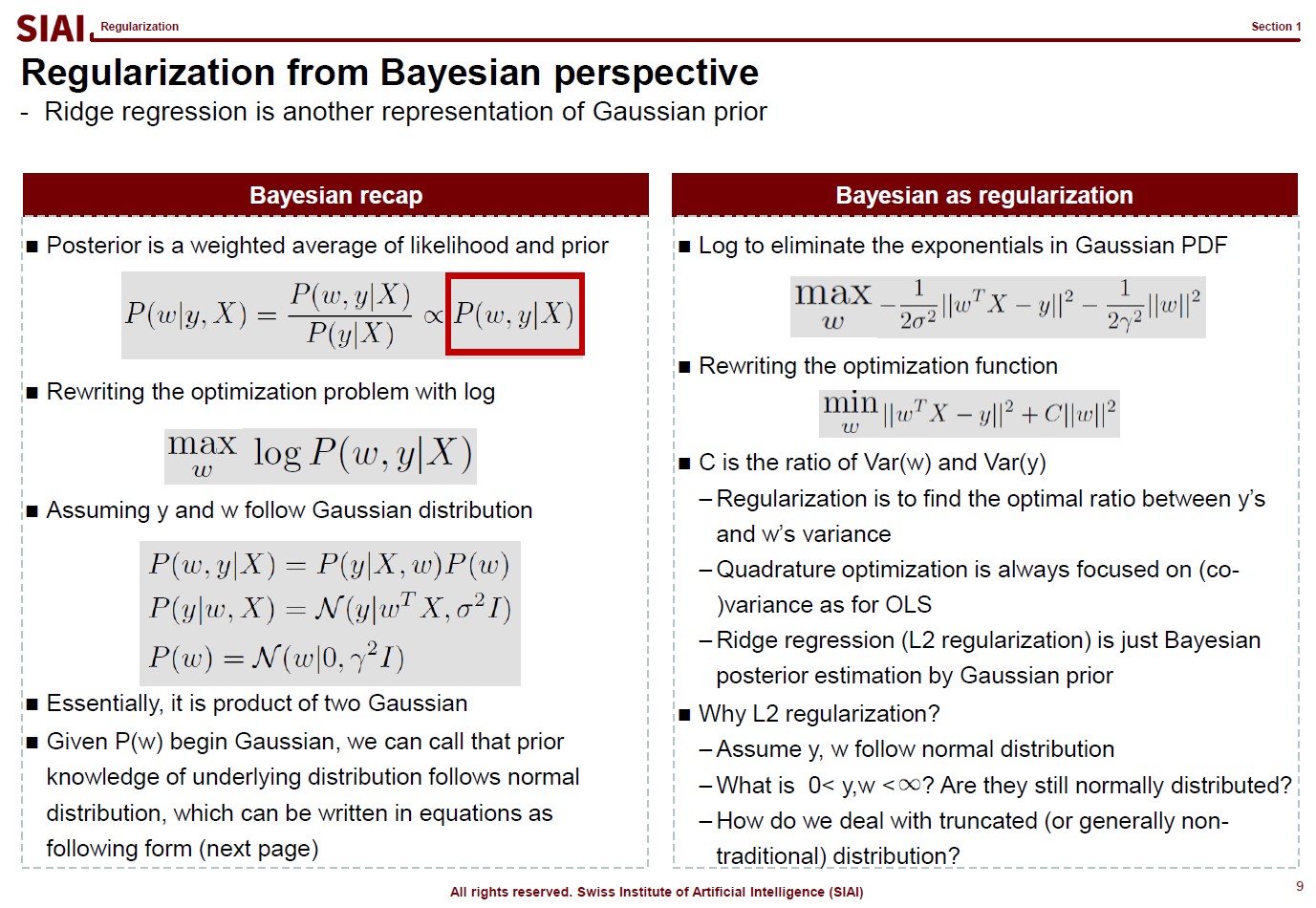

Now let's thinkg about where this L2 regularization really is rooted. If we are lucky enough, we may be able to process the same for L1.

Think of an Bayesian regression. All regressions relies on the idea that given $X$, your combination of $w$ with respect to $y$ helps you to find the optimal $w$. By the conditional probability rule that we use in Bayesian decomposition, the regression can be re-illustrated as the independent joint event of $P(y|X,w)$ and $P(w)$. (Recall that $P(X, Y) = P(X) \times P(Y)$ means $X$ and $Y$ are independent events.)

If we assume both $P(y|X,w)$ and $P(w)$ normal distribution, on the right side of the above lecture note, we end up with the regularization form that we have seen a few pages earlier. In other words, the L2 regularization is the same as an assumption that our $w$ and $y|X$ follows normal distribution. If $w$ does not follow normal, the regularization part should be different. L1 means $w$ follows Laplace.

In plain English, your choice of L1/L2 regularization is based on your belief on $w$.

You hardly will rely on regularizations on a linear function, once you go to real data work, but above discussion should help you to understand that your choice of regularization should reflect your data. After all, I always tell students that the most ideal ML model is not the most fitted to current sample but most DGP* fitted one. (*DGP:Data Generating Process)

For example, if your $w$s have to be positive by DGP, but estimated $w$ are closed to 0, vanilla L2 regularization might not be the best choice. You either have to shift the value far away from 0, or rely on L1, depending on your precise assumption on your own $w$s.

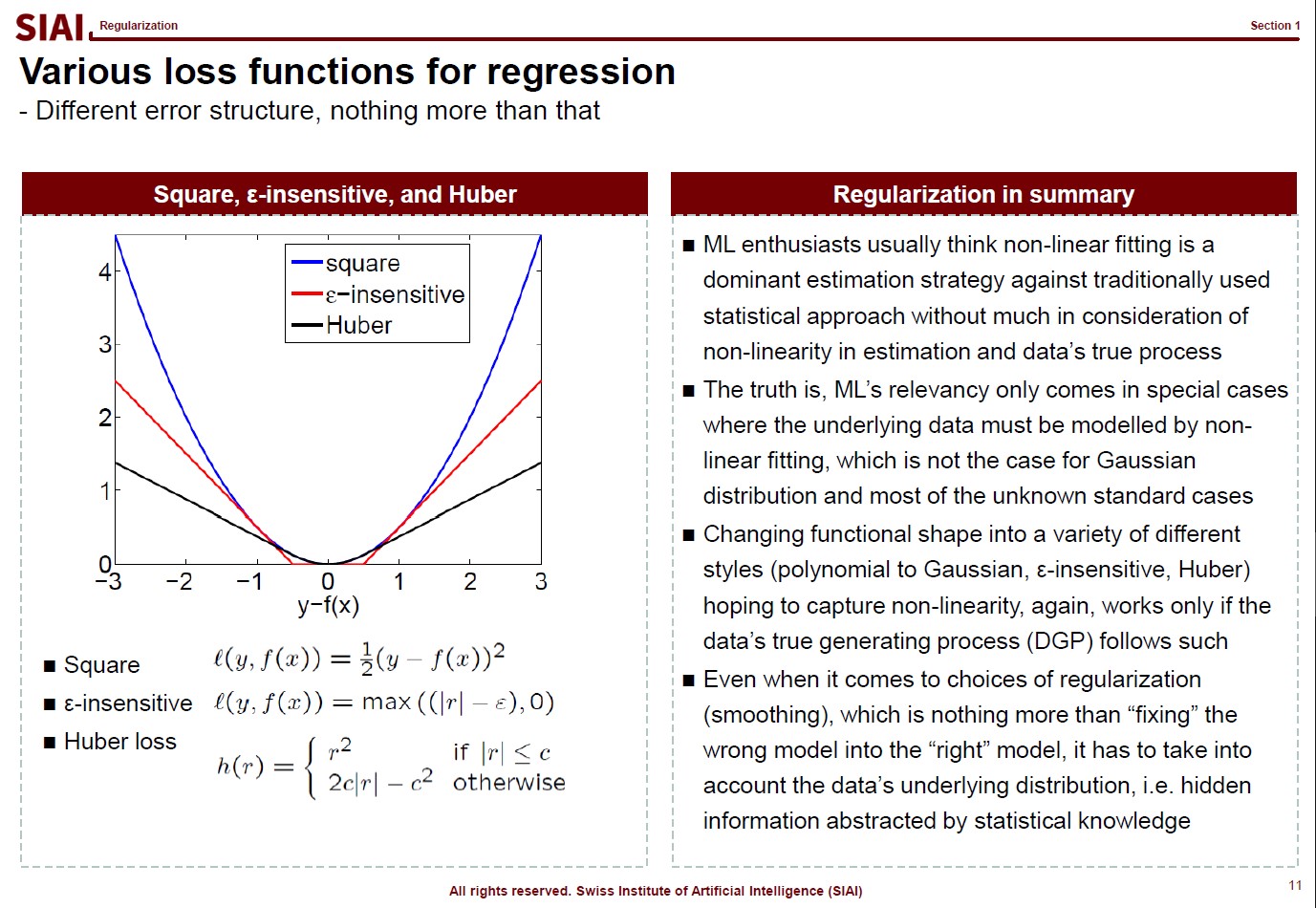

Just like your $w$ reflects your assumption that yields the quadratic form for normal distribution, your loss function also reflects your assumption on $y|X$. As before, your DGP rules what can be the best choice of loss function.

DGP matters in every estimation/approximation/fitting strategies. Many amateur data scientists claim a victory for an higher fit, but no consideration to DGP means you are just lucky to come up with a fitted model for that particular data. Unless you data is endlessly repeated, the luck may not last.

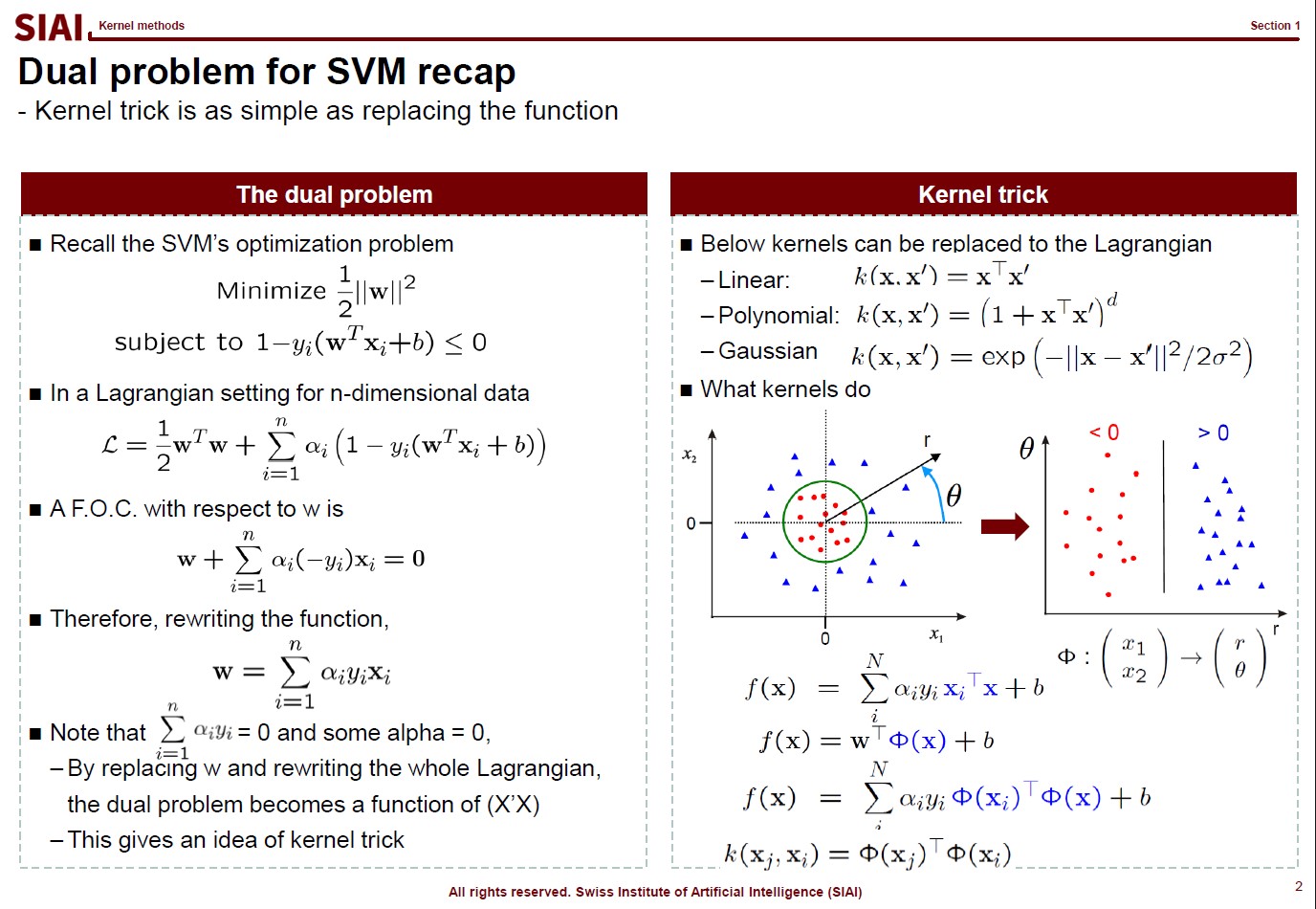

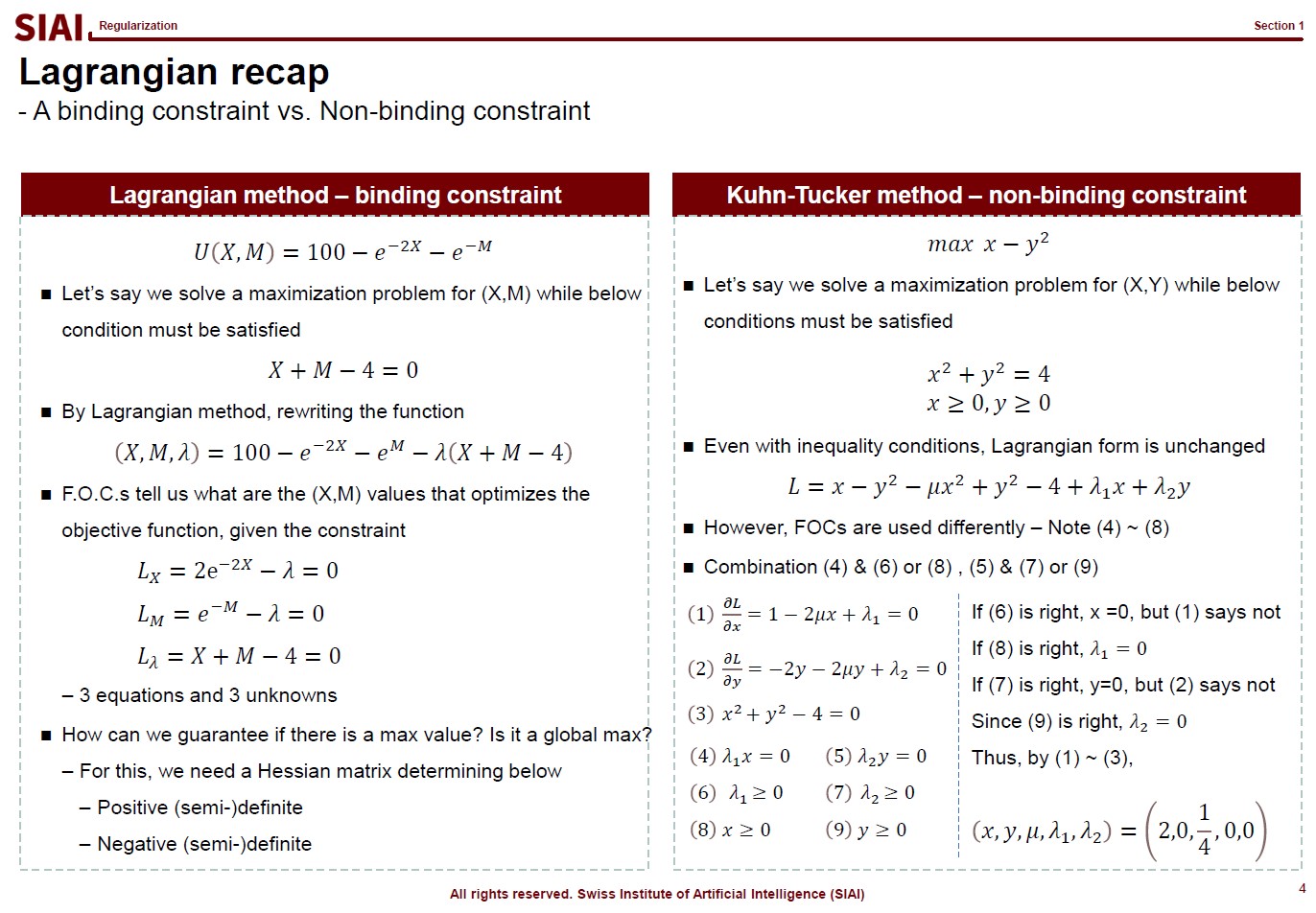

Before we jump onto the famous SVM(Support Vector Machine) model, let's briefly go over related math from undergrad linear algebra. If you know what Kuhn-Tucker is, skip this section and move onto the next one.

Let's think about a simple one variable optimization case from high school math. To find the max/min points, one can rely on F.O.C. (first order condition.) For example, to find the minimum value of $y$ from $y=x^2 -2x +1$,

The $x$ value that make the FOC equal to 0 is $x=1$. To prove if it gives us minimum value, we do the S.O.C. (second order condition).

The value is larger than 0, thus we can confirm the original function is convex, which has a lower bound from a range of continuous support. So far, we assumed that both $x$ and $y$ are from -$\infty$ to +$\infty$ . What if the range is limited to below 0? Your answer above can be affected depending on your solution from FOC. What if you have more than $x$ to find the optimalizing points? What if the function looks like below:

Now you have to deal with two variables. You still rely on similar tactics from a single variable case, but the structure is more complicated. What if you have a boundary condition? What about more than one boundary conditions? What about 10+ variables in the objective function? This is where we need a generalized form, which is known as Lagrangian method where the mulivariable SOC is named as Hessian matrix. The convex/concave is positive / negative definite. To find the posi-/nega-tive definiteness, one needs to construct a Hessian matrix w/ all cross derivative terms. Other than that, the logic is unchanged, however many variables you have to add.

What becomes more concerning is when the boundary condition is present. For that, your objective function becomes:

Instead of solving a two ($x$, $y$) variable problem, one just needs to solve a three ($x$, $y$, $\lambda$) variable problem. Then, what if the boundary condition is no longer given with equality($=$)? This is where you need Kuhn-Tucker technique. (An example is given in the RHS of the above lecture note screen shot).

Although the construction of the objective function with boundary condition is the same, you now need to 'think' to fill the gap. In the above example, from (4), one can say either $\lambda_1$ or $x$ is 0. Since you have a degree of freedom, you have to test validities of two possibilities. Say if $x=0$ and $\lambda_1>0$, then (1) does not make sense. (1) says $\lambda_1 = -1$, which contradicts with boundary condition, $\lambda_1 >0$. Therefore, we can conclude that $x>0$ and $\lambda_1=0$. With similar logic, from (5), you can rule out (7) and pick (9).

This logical process is required for inequality boundaries for Lagrangian. Why do you need this for SVM? You will later learn that SVM is a technique to find a separating hyperplane between two inequality boundary conditions.

Many people think machine learning is some sort of magic wand. If a scholar claims that a task is mathematically impossible, people start asking if machine learning can make an alternative. The truth is, as discussed from all pre-requisite courses, machine learning is nothing more than a computer version of statistics, which is a discipline that heavily relies on mathematics.

Once you step aside from basic statistical concepts, such as mean, variance, co-variance, and normal distribution, all statistical properties are built upon mathematical language. In fact, unless it is purely based on experiments, mathematics is a language of science. Statistics as a science is no exception. And, machine learning is a computational approach of statistics, which we call computational statistics.

Throughout this course, it is introduced that all machine learning topics are deeply based on statistical properties. Although the SIAI's teaching relies less on math more on practical applications, it is still required to learn key mathematical backgrounds, if to use machine learning properly. If you skip this part, then you will be one of the amateurs arguing machine learning (or any computational statistical sub-disciplines) as a magic.

To answer why machine learning become suddenly popular, you first have to understand what it really does. Machine learning helps us to find a non-parametric function that fits to data. Non-parametric means that you do not have a specific functional shape, like $y=a \cdot x^2 + b \cdot x + c$. Once you step away from linear representation of the function, there can be infinite number of possibilities to represent a function. $y=f(x)$ can be a combination of exponential, log, or any other form you want. As long as it fits to data, why care so much?

Back then, fitting to data was only the first agenda. Because the data in your hand is only a sample of the giant population. For example, if a guy claim that he can perfectly match stock price movements for the last 3 years for a specific stock. Then, amateurs are going to ask him if

If the stock price returns are randome, a fit for sample data cannot be replicated to other sets of data, unless miracle occurs. In mathematical terms, we call it a probability $\frac{1}{\infty}$ event. If you have done some stochastic calculus, it can be said that the probability converges to 0 almost surely (a.s.).

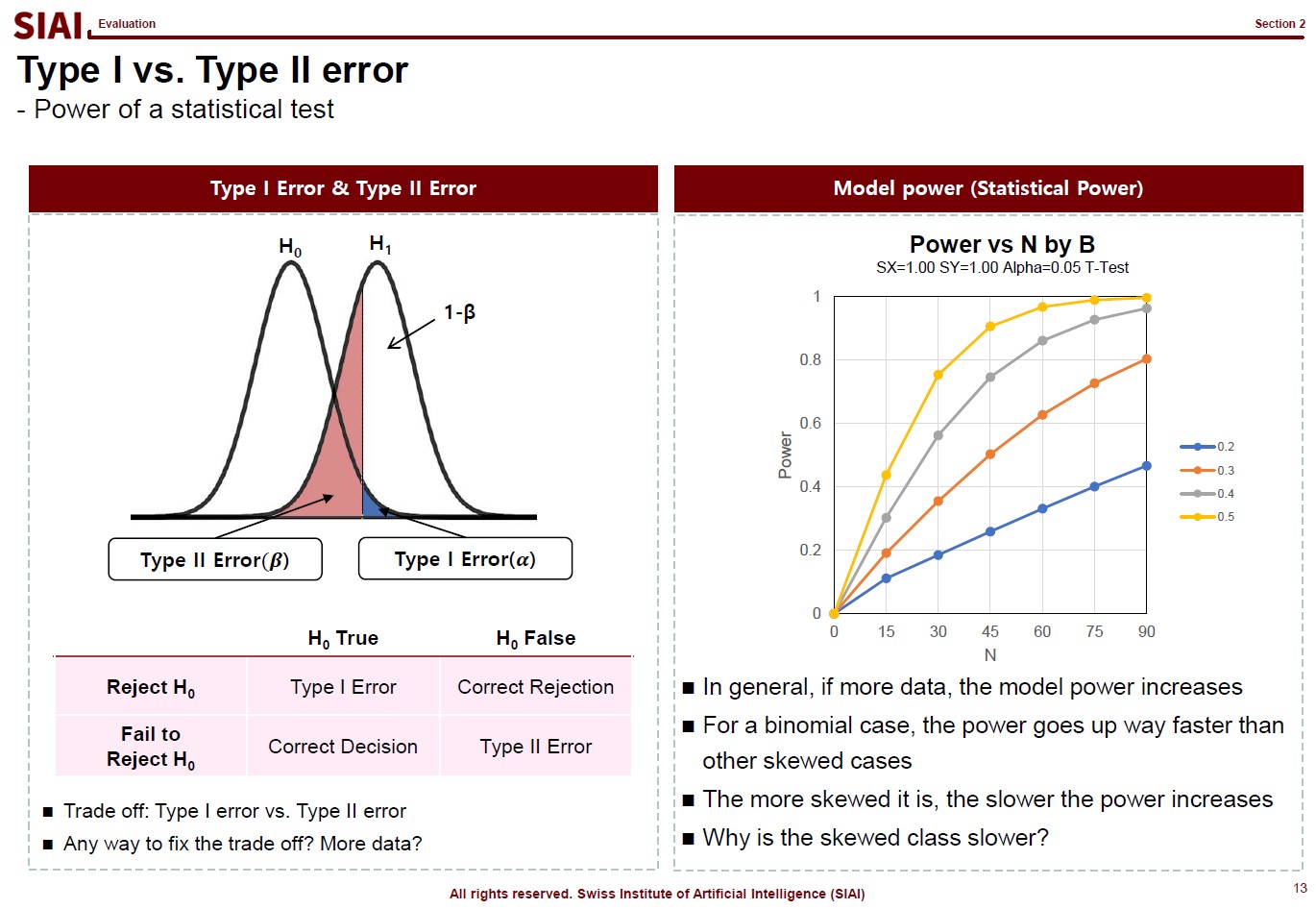

Here, the second agenda arises, which is minimizing model variance for generality of the model. In statistics, it is often done by Z-test, t-test, $\chi^2$-test, and F-test. Although the statistical tests based on (co-)variance (or 2nd-moments, in more scientific terms) is not universal solution to claim generality of the model, if conditions fit, we can argue that it is fairly good enough. (Conditions that can be satisfied if you data follows normal distribution, for example).

Unfortunately, machine learning hardly addresses the second one. Why? Because machine learning relies on further assumptions. The 2nd-moment should be irrelevant for it to work. What are the data sets that overrules the 2nd-moment tests? Data that does not follow random distribution, thus does not have variance. Data that follows rules.

In short, machine learning is not for random data. The quest to find an ultra complicated function should be rewarding, and the probability is guaranteed if such funcational events are highly frequent. Examples of such events are like language. You do not speak random gibberish for daily conversation. (Assuming that you do not read this text in a psychiatric hospital.) As long as your language has a grammar and a dictionary for vacabulary, that means there is a rule and it is repeated, thus highly frequent.

Out of many other reasons that machine learning suddenly becomes popular, one thing that can be told is that we now have a plethora of highly frequent data with certain rules. You do not need bigtech companies to build a peta-byte database of text, image, and any other contents with rules. Finding a linear functional form, like $y=a \cdot x^2 + b \cdot x + c$, for such data is mostly next to impossible. Then, what is an ideal alternative? Is there any alternative? Remember that machine learning helps us to fit such a complicated function.

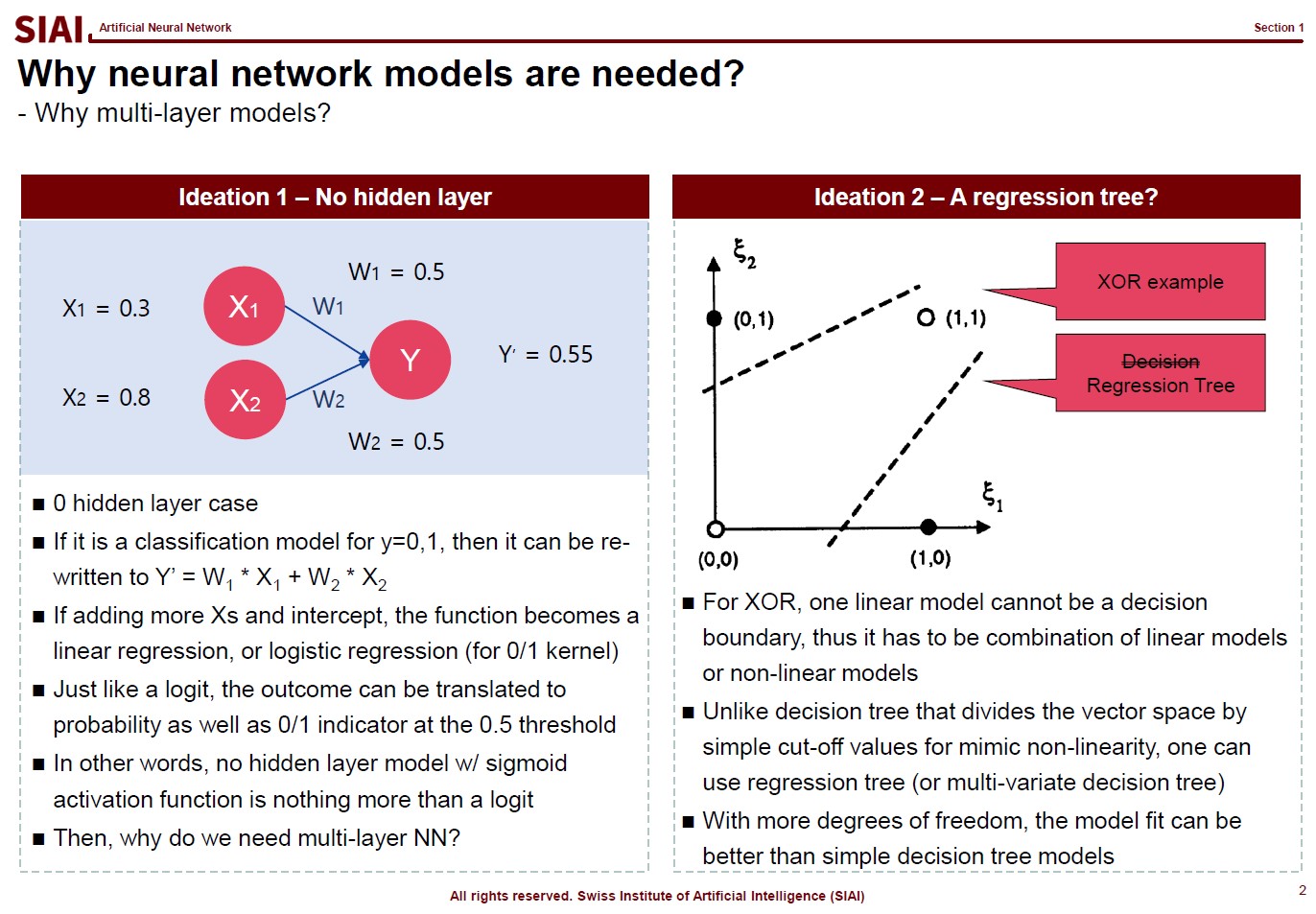

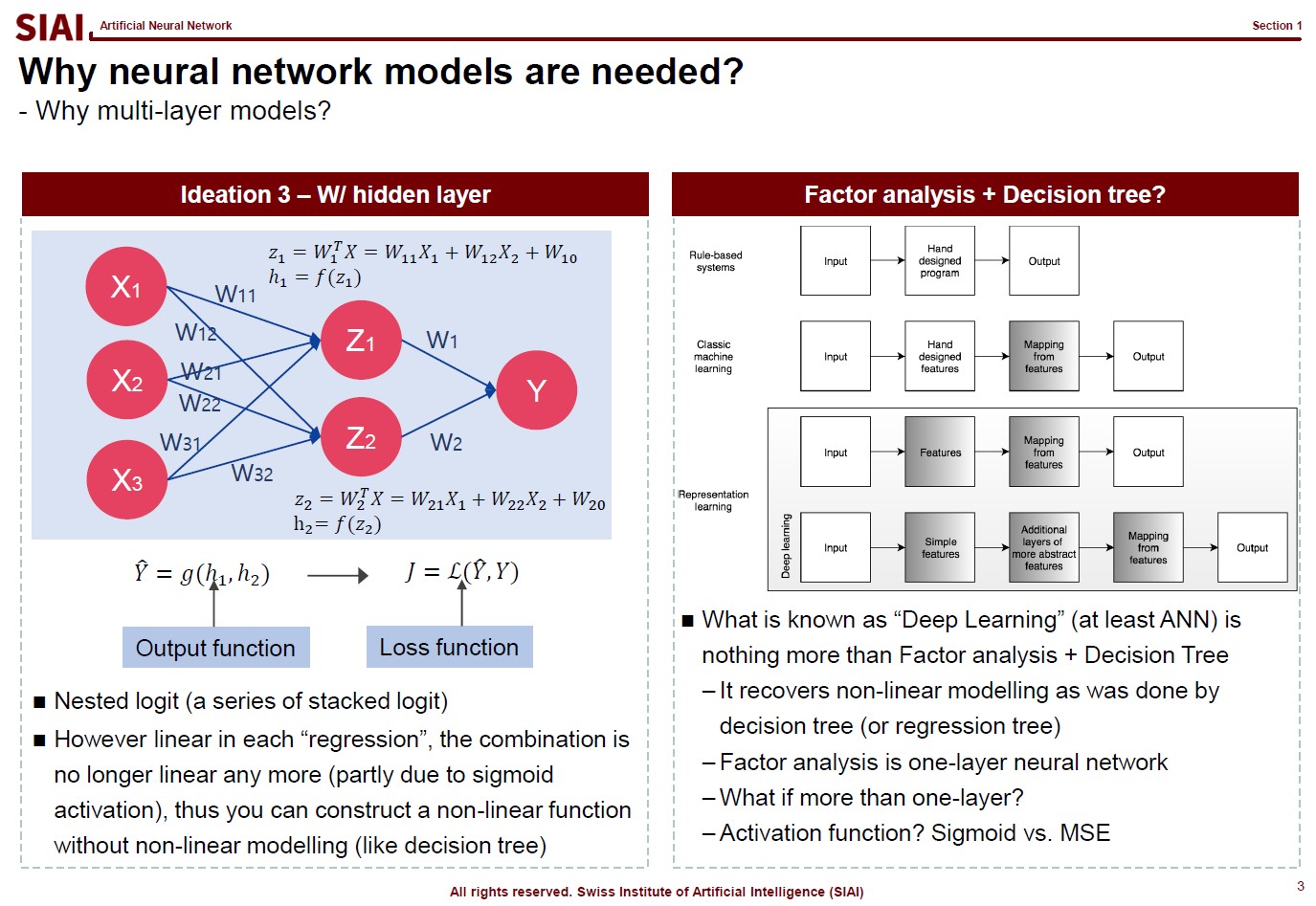

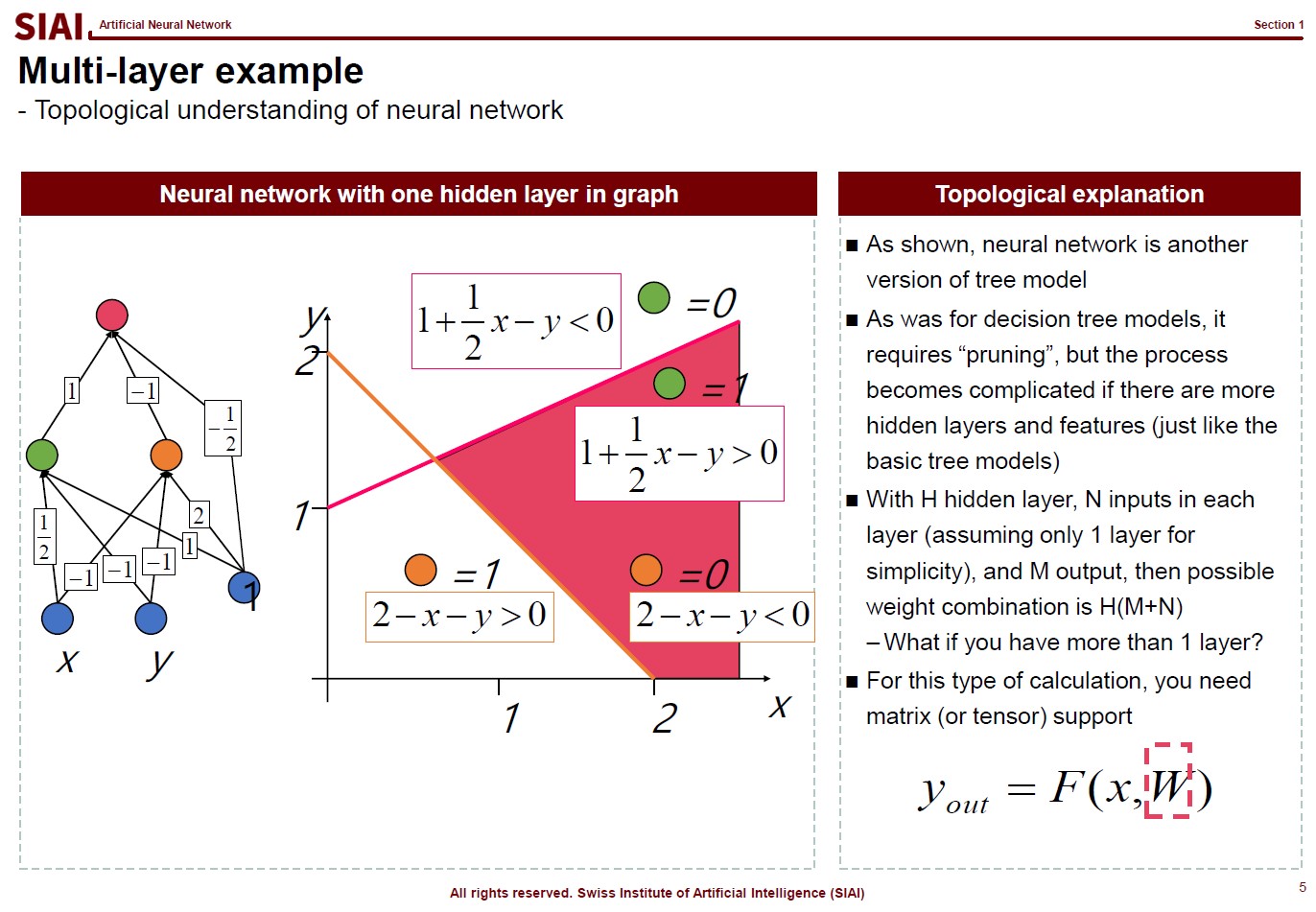

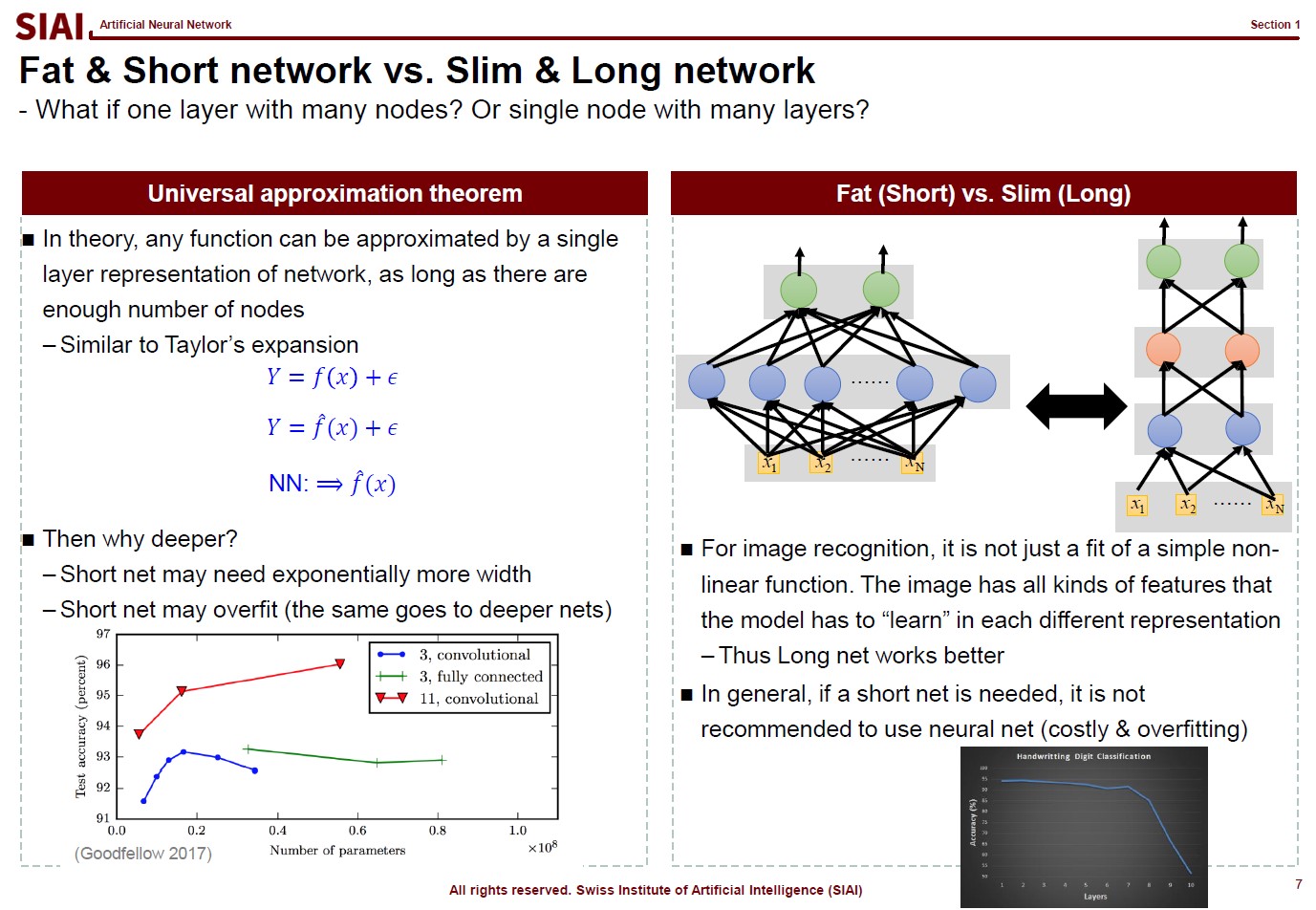

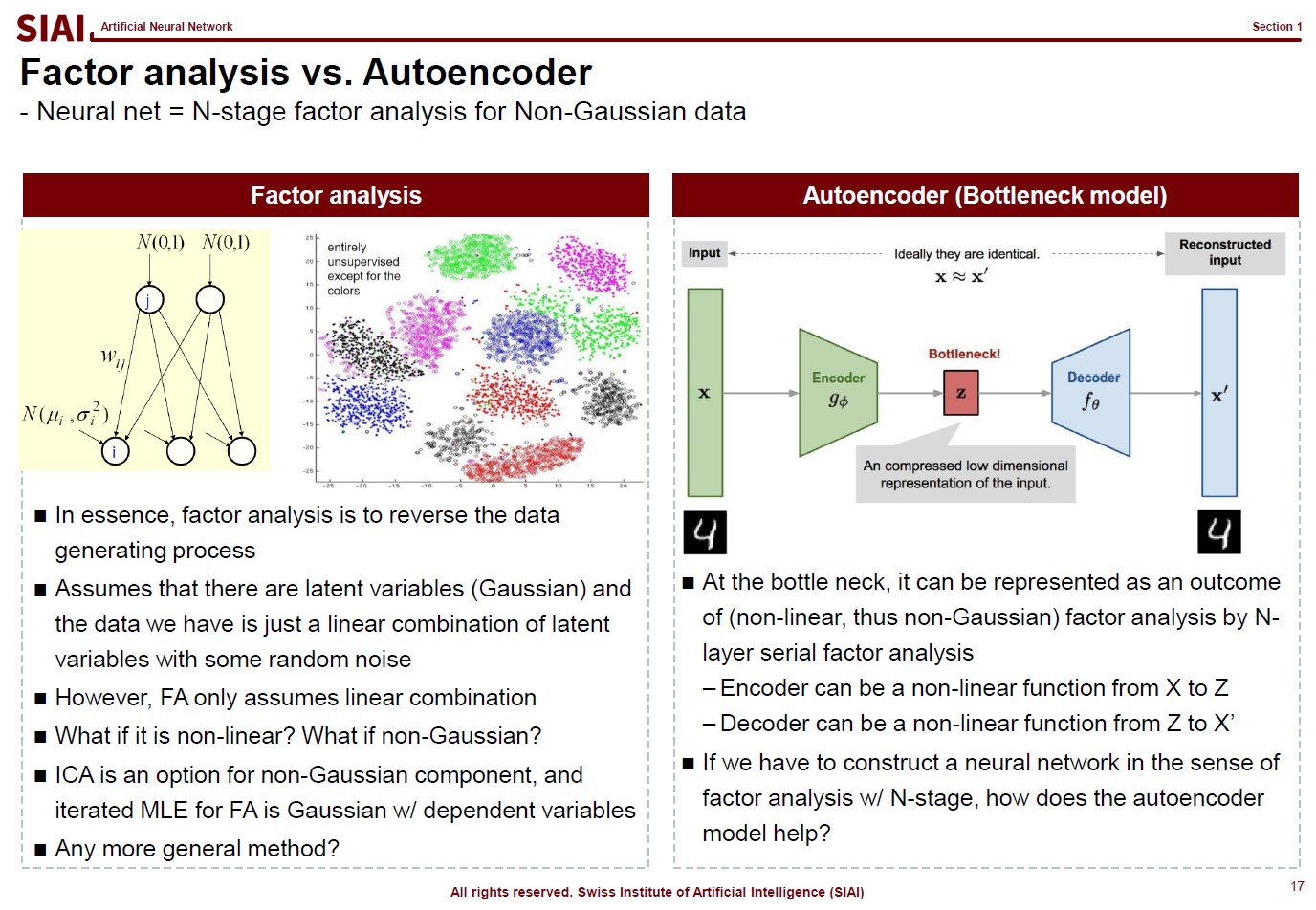

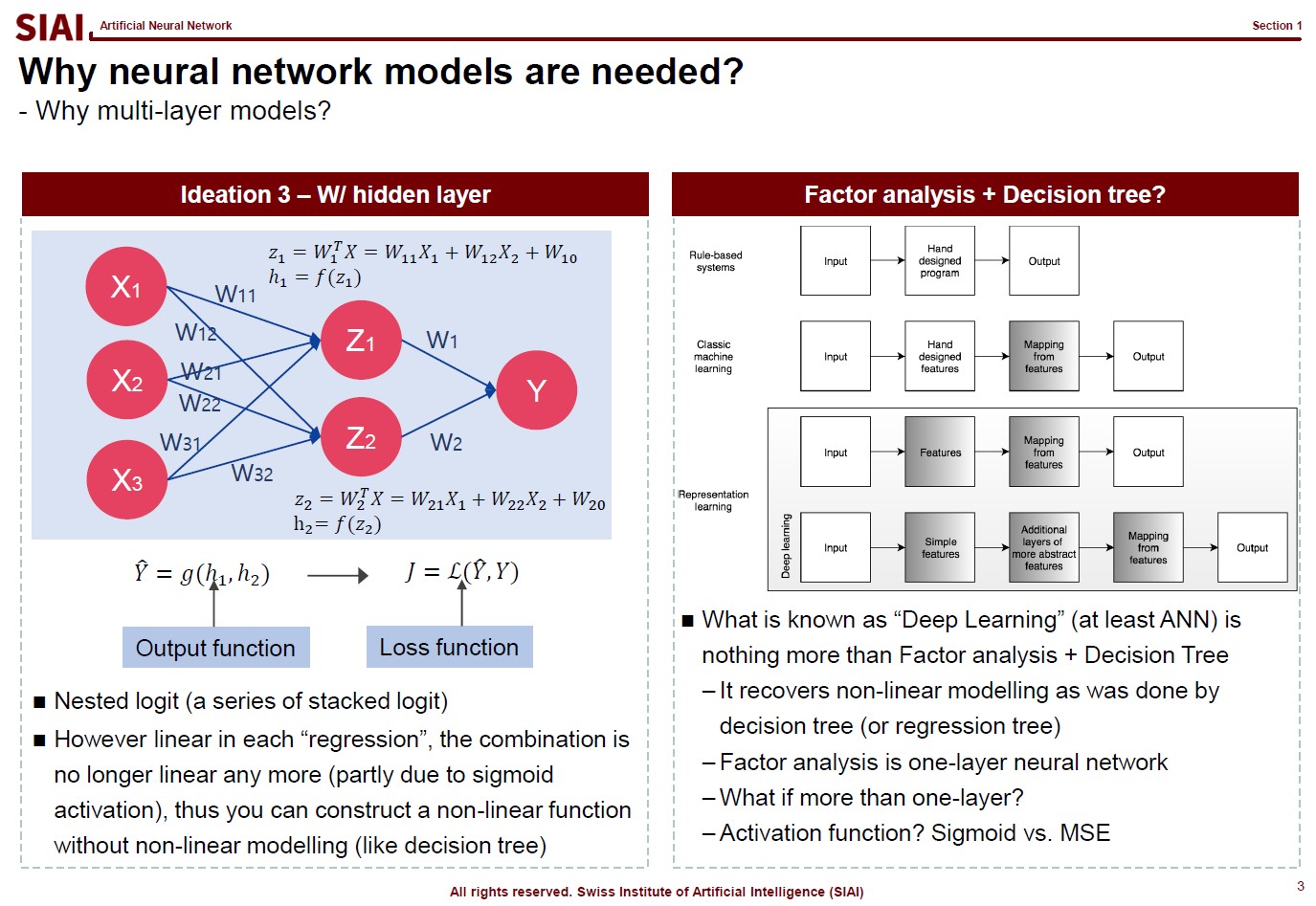

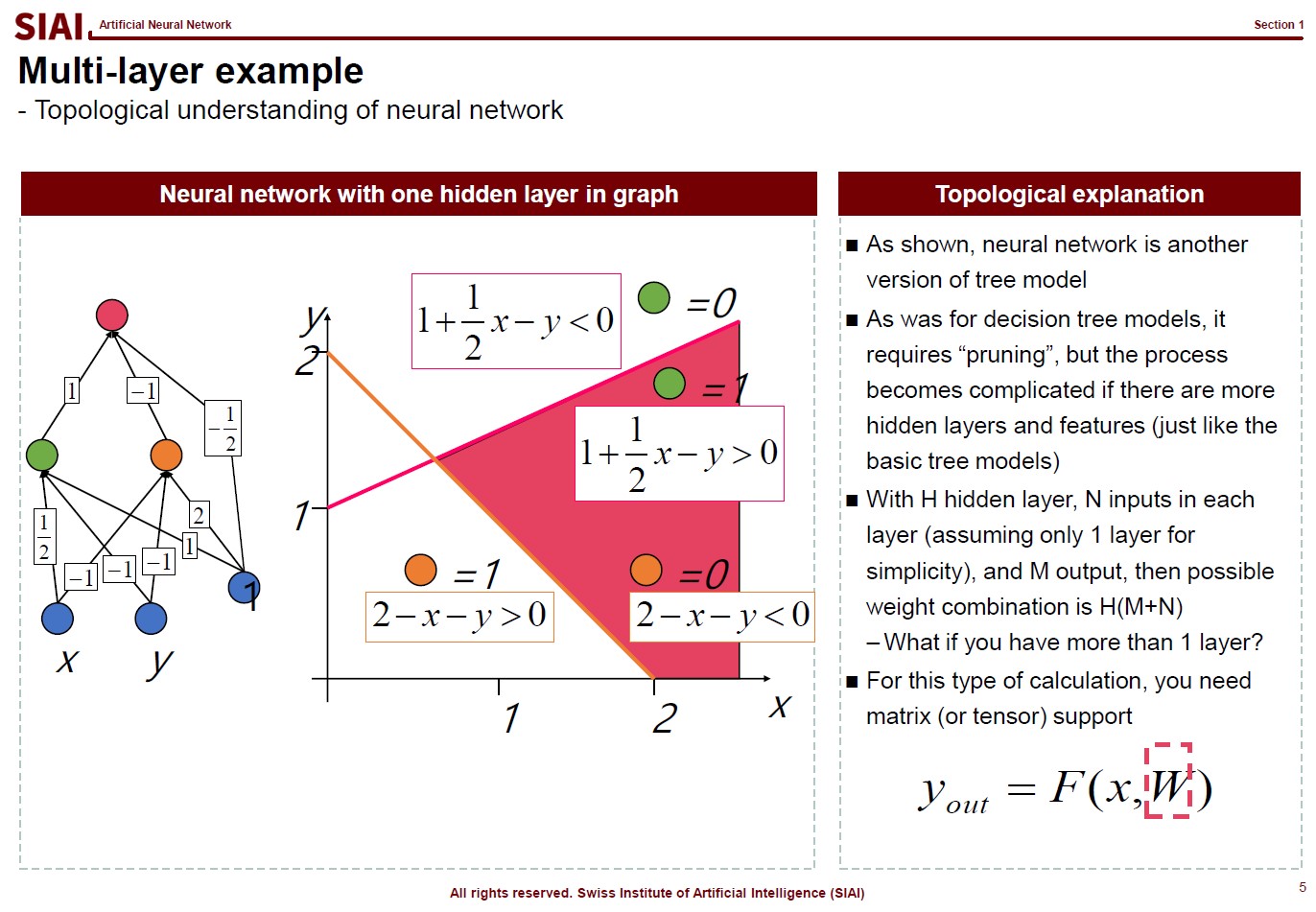

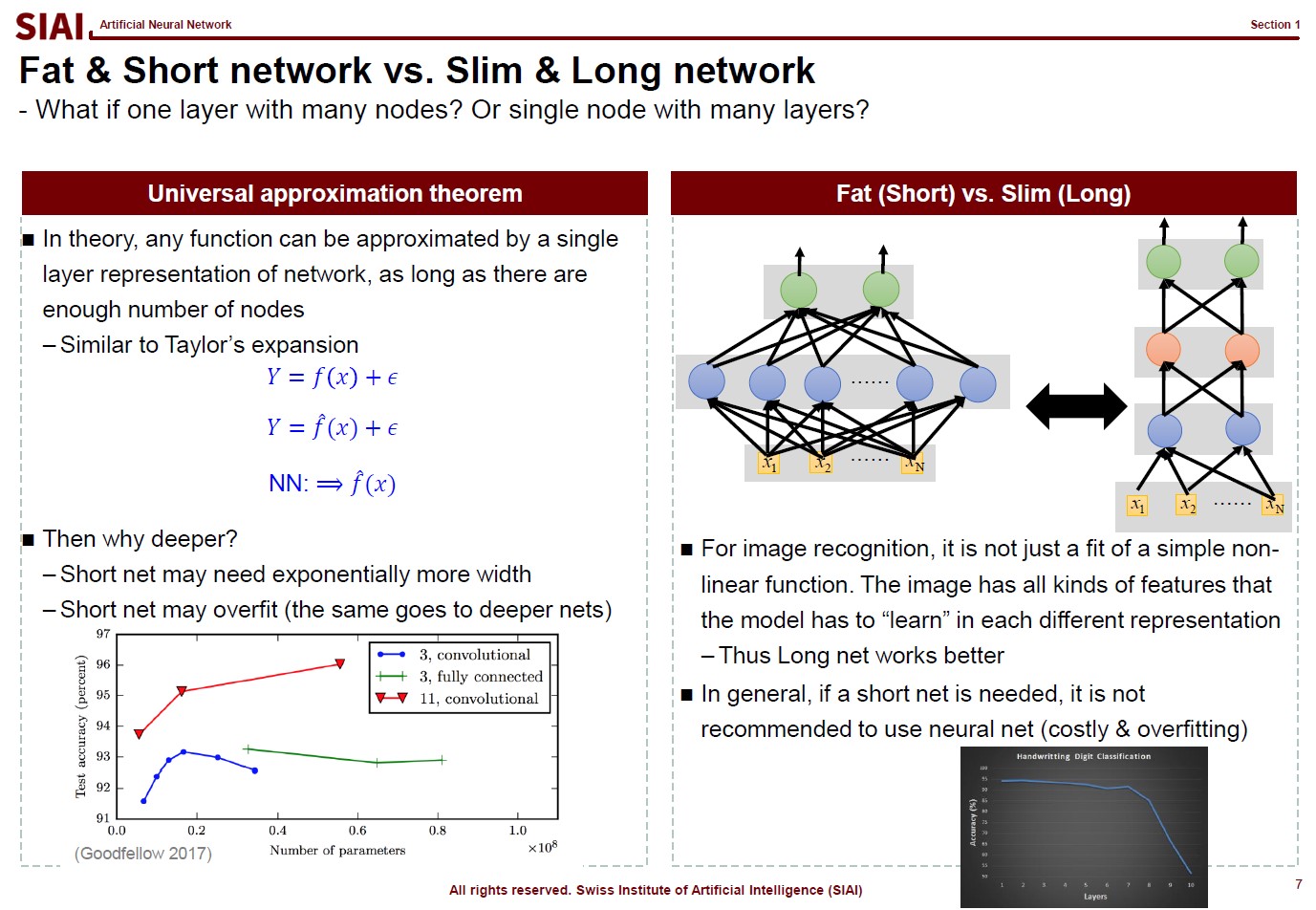

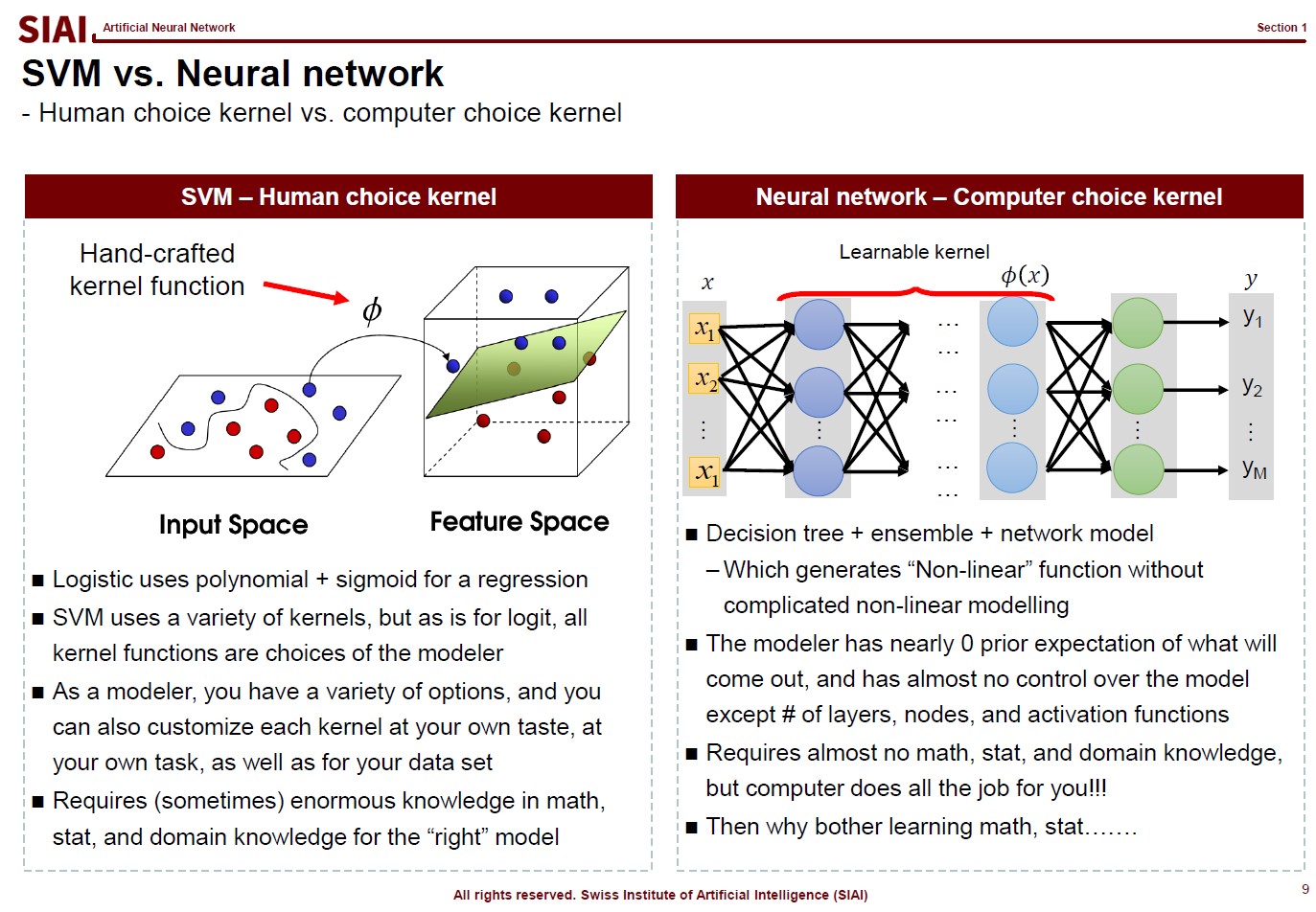

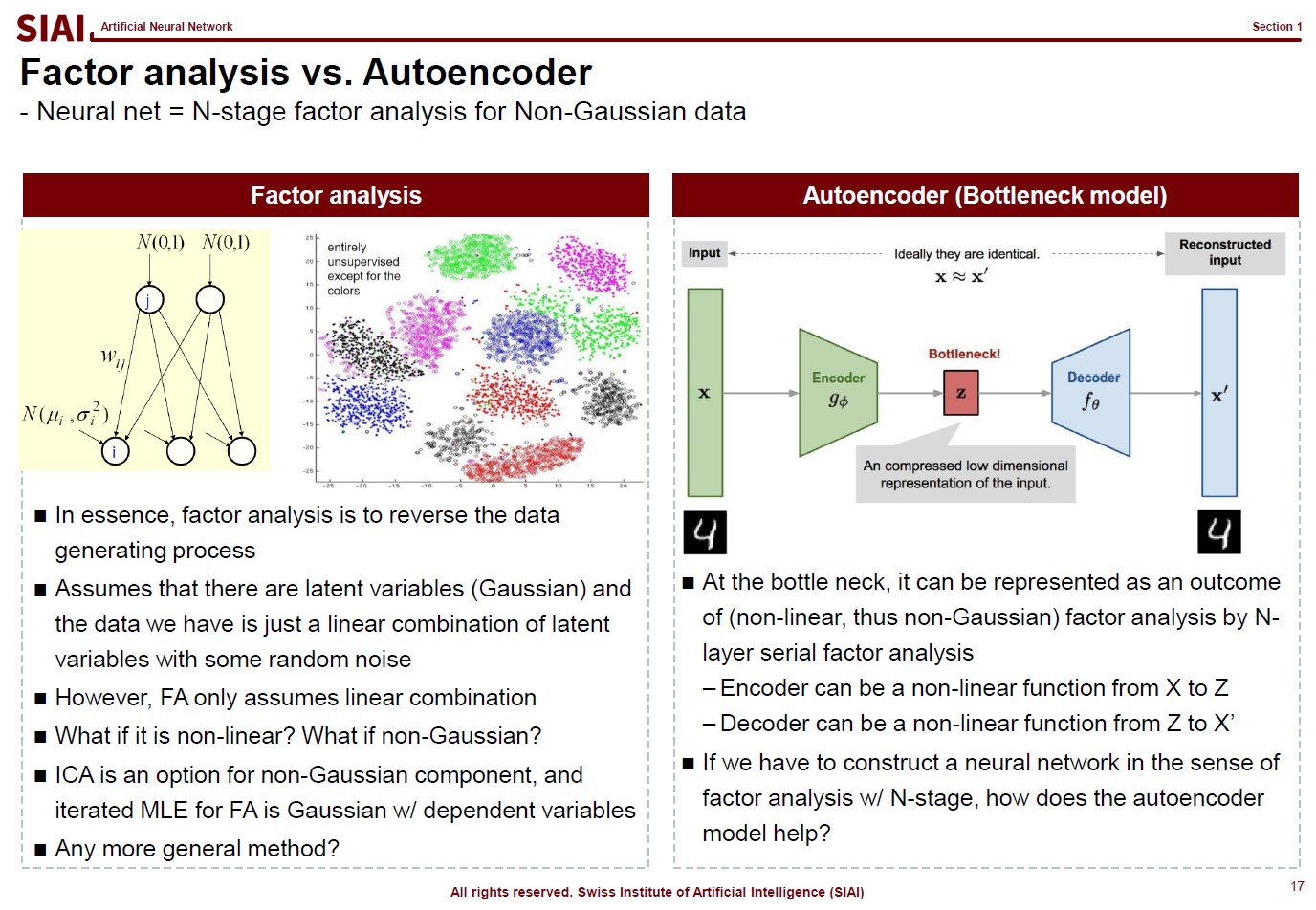

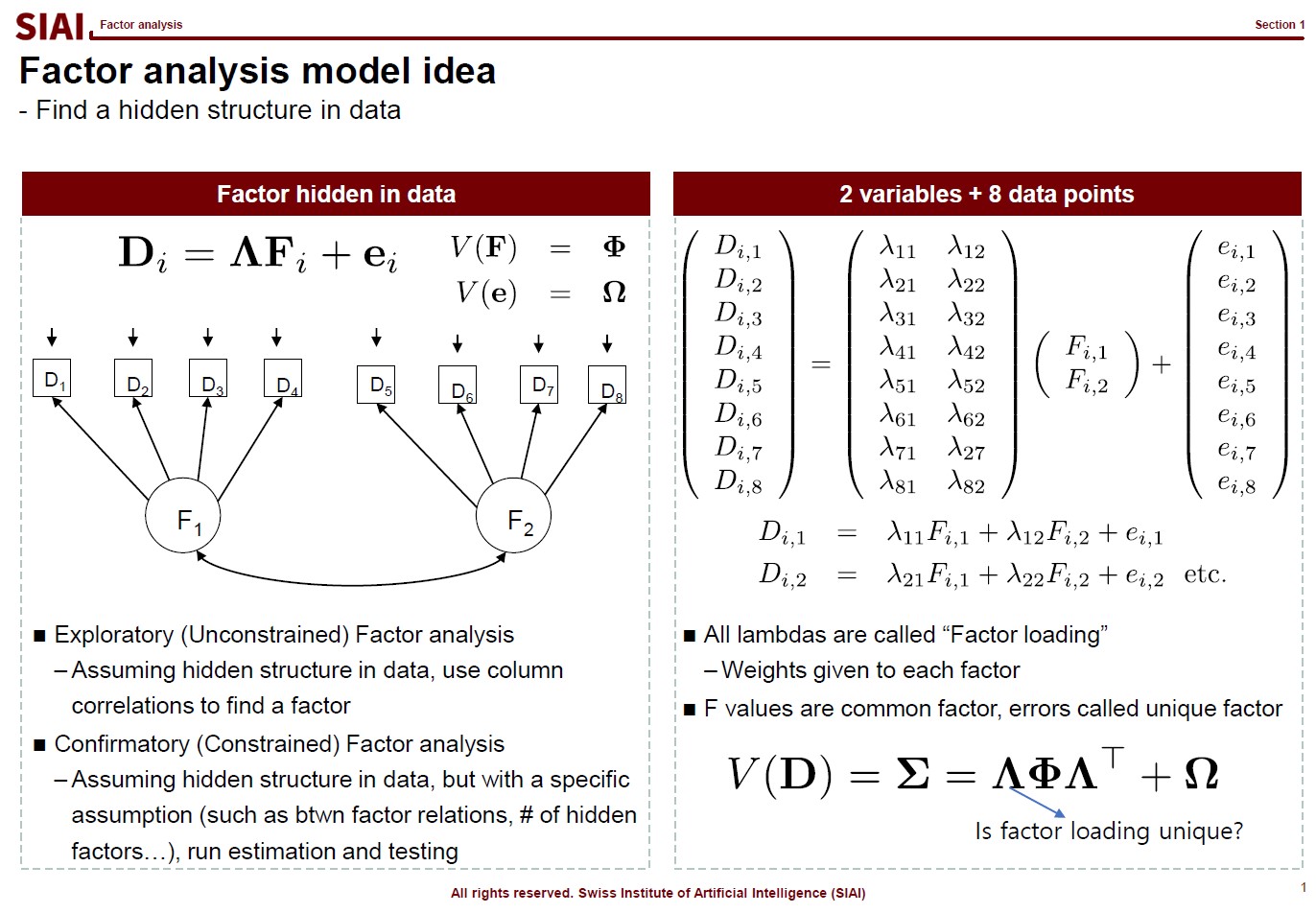

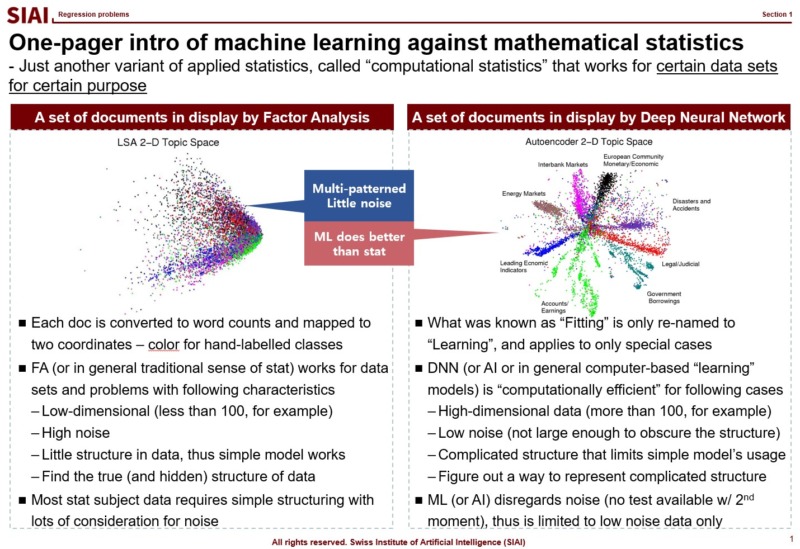

The first page of this lecture note then starts with an example of traditional statistics that fails to find such a function. In the above screenshot, on the left, factor analysis cannot help us to differentiate data sets of 0~9. There are 10 types of data, but factor analysis was not able to find key characteristics of each type. It is because the combination of characters are complicated, and a simple function cannot find the decent fit. For example, number 3 and 9 have the similar shape on the upper right part and bottom center part. Number 5 and 9 have the similar bottom right part. Number 0 and 9 also share the upper right part and the bottom right part. You need more than a simple function to match all combinations. This is where multi-layer factor analysis (called Deep Neural Network) can help us.

Throughout the course, just like above, each machine learning topic will be introduced in a way to overcome given trouble that traditional statistics may not solve easily. Note that it does not mean that machine learning is superior to traditional statistics. It just helps us to find a highly non-linear function, if your computer can do the calculation. Possibilities are still limited and often explained in mathematical format. In fact, all machine learning jargons have more scientific alternative, like multi-layer factor analysis to Deep Neural Network, which also means there is a scientific back-up needed to fully understand what it really does. Again, computational methods are not magic. If you want to wield the magic wand properly, you have to learn the language of the 'magic', which is 'mathematics'.

Most simpliest possible machine learning is to find a non-linear fit of a data set. As you have more and more data points, the function to match all points is necessarily going to have more ups and downs, unless you have a data set fits to a linear function. Thus, if you have more data, it is likely that you are going to suffer from less fit with abundant error or more fit with complication in function.

As discussed above, machine learning approaches are to find a fit, or 1st-moment (mean, average, min, max...), which assumes that data set is repeated in out of sample. As long as it fits to data in hand, machine learning researchers assume that it fits to all other data in the same category. (This is why a lot of engineers, after the 1st lecture of machine learning, claim that they can find a fit to stock price movements and make money in the market. They don't understand that financial markets are full of randomness.)

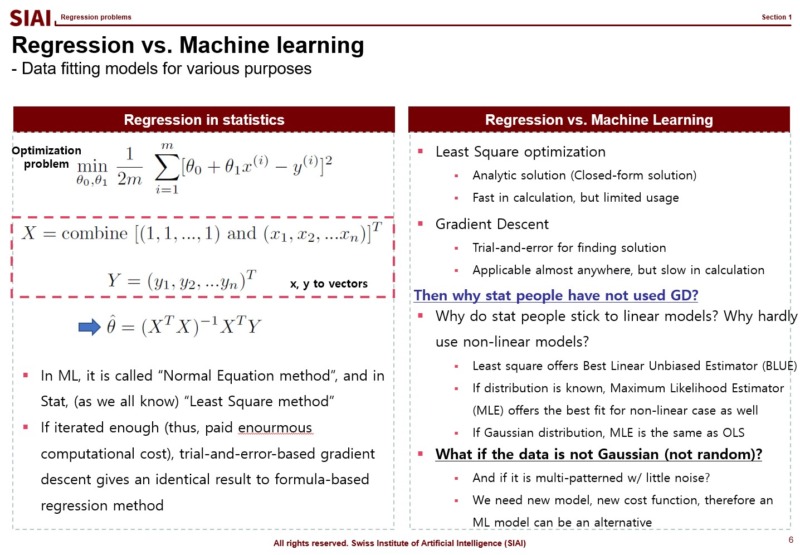

In statistics, the simplest form of regression is called ordinary least square (OLS). In machine learning, the OLS solution is called 'Normal equation' method. Why are they end up with the same form of the solution?

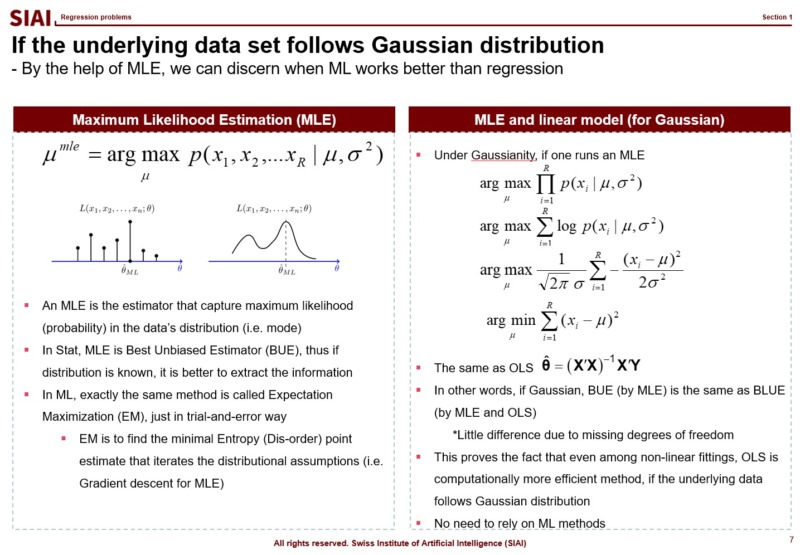

This happens only when the OLS is the most optimal fit to given data set, which is coined as 'Best Linear Unbiased Estimator (BLUE)' in statistics, where one condition for OLS to be BLUE is the target variable follows normal distribution. To be precise, statistians say that $y$ is normally distributed conditional on $X$, or $y|X \backsim N(\beta \cdot X, \sigma^2)$. Given your explanatory variables, if your target variable follows normal distribution, your machine learning model will give you exactly the same solution as OLS. In other words, if you have normally distributed random data, then you don't have to go for machine learning models to find the optimal fit. You need machine learning models when your target variable is not normally distributed, and it is not random.

Just to note that if your data follows a known distribution, like Poisson, Laplace, Binomial..., there is a closed-form BLUE solution, so don't waste your computational cost for machine learning. It's like high school factorization. If you know the form, you have the solution right away. If not, you have to rely on a calculator. For questions like $x^2 - 2x +1 =0$ is simple, but complicated questions may require enourmous amount of computational cost. You being smart is the key cost saving for your company.

In real world, hardly any data (except natural language and image) have non-distributional approximation. Most data have proxy distribution, which gives near optimal solution with known statistics. This is why elementary statistics only teach binomial (0/1) and Gaussian ($N(\mu, \sigma^2)$)distribution cases. Remember, machine learning is a class of non-parametric computational approach. It is to find a fit that matches to unknown function. And, it does not give us variance for testing. The entire class of machine learning models assume that there are strong patterns in the data set, otherwise a model without out of sample property is not a model. It is just a waste of computer resource.

Think of an engineer claiming that he can forecast stock price movements based on previous 3 years data. He may have a perfect fit, after running a computational model for years (or a lot of electric power and super expensive graphics card.) We know that stock prices are deeply exposed to random components, which means that his model will not fit for the next 3 years. What would you call the machine learning model? He may claim that he needs more data or more computational power. Financial economists would call them amateurs, if not idiots.

Then, one may wonder, what about data sets that fit better with non-linear model? In statistics, maximum likelihood estimators (MLE) are known as the best unbiased estimator (BUE), as long as the distributional shape is known. And, if the distribution is normal, as discussed in earlier slides, it matches exactly the same as OLS. (Note that variance is slightly different due to loss of degrees of freedom, but $N-1$ and $N$ are practically the same, if $N \rightarrow \infty$.)

In general, if the model is limited to linear class models, simple OLS (or GLS, at best) is the optimal approach. If the distributional shape is known, MLE i the best option. If your data does not have known distribution, but needs to find a definitive non-linear pattern, that's when you need to run machine learning algorithms.

Many amateurs blatantly run machine learning models and claim that they found the most fitted solution, like accuracy rate is 99.99%. As discussed, with machine learning, you cannot do any out of sample test. You might be 99.99% accurate for today's data, but you cannot guarantee that tomorrow. Borrowing the concept of computational efficiency from COM501:Scientific Programming, machine learning models are exposed to larger MSE and more computational cost. Therefore, for data sets OLS and MLE are the best fit, all machine learning models are inferior.

Above logic is the centerpiece of COM502: Machine Learning, and in fact is the single most important point of the entire program at SIAI. Going forward, for every data problem that you have, the first question you have to answer is if you need to rely on machine learning models. If you stick to it despite random data set closed to Gaussian distribution, you are a disqualified data scientist.

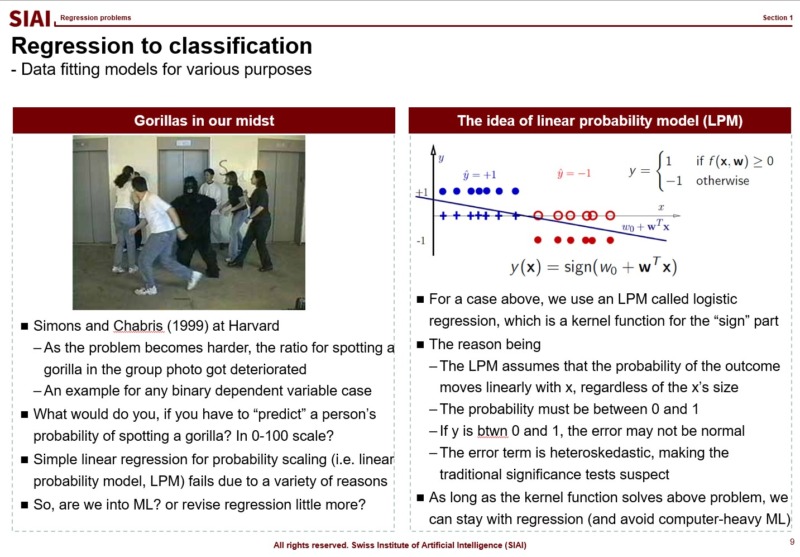

What if the outcome that you have to find the fit is no longer a continuous value from 0 to 100, or -$\infty$ to $\infty$? In mathematics, we call this as 'support', meaning that your value's range. in other words, by the mathematical jargon, if your target variable's support is 0/1 or Yes/No, your strategy might be affected, because you no longer have to match a random variable following normal distribution. We call 0/1 value cases as 'binomial distribution', and it requires different approximation strategy.

One that has been widely used is to apply a kernel function, which transforms your value to another support. From your high school math, you should have come across $y=f(x)$, (if not, your trial to learn ML is likely going to be limited to code copying only), a simplest form that tells us that $x$ is transformed to $y$ by function $f$. The function can be anything, as long as it converts $x$ to $y$, without any slag. (Mathematically, we call that $f$ is defined on $x$.)

If the transformation function $f$ maps value $x$ to 0~1, or Yes/No, we can fit Yes/No cases, just like we did with normal distribution.

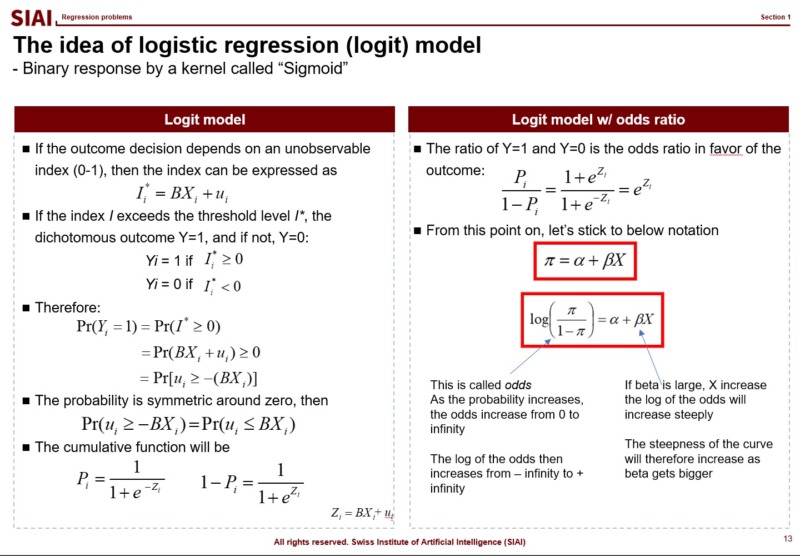

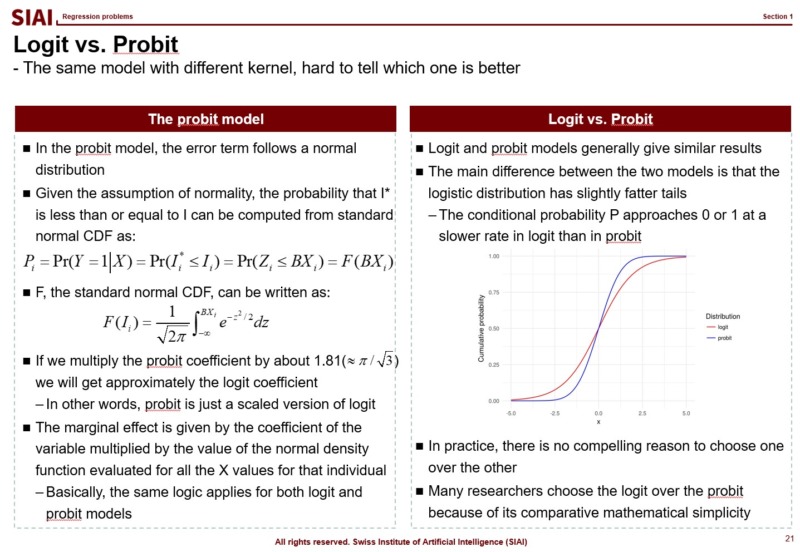

There are two widely adapted transformation $f$, Logit and Probit. As you can see from above lecture note, Logit coverts the $x$ value by odds ratio. Unfortunately, there is no closed form solution to calculate the ratio with hands, so we follow Newton methods, which we learned from COM501: Scientific Programming. The approach relies on the idea that likelihood of the value to be 0 vs. ths same probability to be 1. The ratio can be varying from -$\infty$ to +$\infty$, but the re-scaling put it into 0~1 frame.

Similarly, Probit transforms the outcome by assuming that it follows normal distribution. There is little to no difference between these two methods, when it comes to the accuracy, if you have large number of independent sample data. In small samples, usually Logit provides smoother value changes than Probit. You had more details of Logit in COM501: Scientific Programming. Check the notes.

발렌시아가·지방시·베르사체 등, 최대 50% 할인

전년 대비 할인율·할인 품목·할인 기간 모두 늘어

韓, 고물가에 중고 매매·할인점·아울렛 매출 증가

글로벌 명품 시장의 최대 소비국 중 하나인 중국의 소비가 위축되면서 명품 브랜드들이 악성 재고 처리에 고심하고 있다. 이에 발렌시아가, 지방시 등 일부 명품 브랜드는 공개 할인에 나서지 않는다는 원칙을 깨고 최대 50% 할인 제품을 쏟아내고 있다. 이런 가운데 명품 시장의 성장세 둔화가 당분간 지속될 것이란 전망이 나오면서 글로벌 명품업계의 위기감은 더욱 고조되고 있다.

블룸버그 통신은 "최근 일부 명품 브랜드가 중국의 대표 전자상거래 플랫폼 '티몰(Tmall)'에서 전례 없는 수준의 가격 할인에 나섰다"며 "소비 감소로 인한 재고 문제를 해소하기 위한 조치"라고 13일(현지시간) 보도했다. 현재 티몰에서는 발렌시아가의 대표 상품인 아워글라스 핸드백이 1,947달러(약 268만원)에 판매되고 있다. 브랜드의 공식 웹사이트와 주요 럭셔리 플랫폼과 비교해 35% 할인된 가격으로 발렌시아가는 올해 들어 3개월째 40% 수준의 할인을 지속하고 있다.

그동안 명품 브랜드들은 중국 시장에 의존해 매출 증대와 실적 개선을 이뤄왔지만 최근 중국 중산층의 소비 수요가 위축되면서 판매량이 감소하고 있다. 이에 발렌시아가 외에도 베르사체, 지방시, 버버리 등도 티몰을 비롯한 중국 내 쇼핑 플랫폼에서 판매가격을 절반 이상 인하했다. 전년 같은 기간과 비교해 할인 폭이 10%p 이상 커지고 할인 기간도 길어졌다. 할인 제품 수도 지난해에는 몇 개에 불과했지만, 올해는 수백 개로 늘어났다.

이에 대해 블룸버그 통신은 "일반적으로 명품 브랜드는 자사 아울렛이나 비공개 세일을 통해 재고를 소진해 왔기 때문에 예전 같으면 이런 공개 할인 행사는 상상할 수도 없었다"며 "그만큼 명품 브랜드가 판매 부진으로 곤경에 처했음을 의미한다"고 분석했다.

한국에서는 고물가가 이어지면서 명품 중고 거래가 주요 패턴으로 자리 잡고 있다. 실제로 국내 대표 중고 명품 플랫폼인 '구구스'의 거래액은 매년 큰 폭으로 증가하고 있다. 구구스의 1분기 거래액은 전년 동기 대비 16% 증가한 624억원을 기록하며 분기 기준 최대치를 경신했다. 브랜드별로 롤렉스의 판매 건수는 전년 동기 대비 31% 늘었고, 에르메스는 21% 증가했다. 품목별로는 의류가 24%, 주얼리가 38% 성장했다.

할인점이나 아울렛을 찾는 수요도 증가하고 있다. 특히 대형 백화점을 중심으로 '오프 프라이스(Off-Price)' 매장이 확대되고 있다. 오프 프라이스 매장은 미국에서 2000년대 초반 등장한 유통 채널의 한 형태로 기업이 브랜드의 재고 상품을 직접 사들인 후 최초 판매가의 최대 80%까지 할인해 판매한다. 신세계백화점은 올해 들어 '팩토리 스토어' 매장을 늘렸으며 현대백화점도 자사의 오프 프라이스 매장 '오프 웍스'를 확장하고 있다.

오프 프라이스 매장과 백화점의 중간 형태인 아울렛은 오프 프라이스 매장보다 할인율은 낮지만 비교적 최근에 출시된 명품을 구매할 수 있다는 장점이 있다. 특히 서울 근교에 위치한 교외형 아울렛은 주말 가족 나들이로 즐길 수 있어 많은 소비자가 찾고 있다. 지난해 전국 33개 아울렛의 매출은 8조6,604억원으로 전년 대비 3.8% 증가했다. 같은 기간 70개 백화점의 매출 증가율 1.7%와 비교하면 2배 이상 높은 수치다.

사실 명품업계는 팬데믹 기간 중 기대 이상 선전을 하며 호황을 누렸다. 많은 사람들이 외부 활동으로부터 격리돼 집에만 머물면서 여가 비용 등을 고가의 명품, 가전·가구를 구입하는 데 썼기 때문이다. 여기에 2020~2022년 기간 중 각국 중앙은행의 저금리 기조와 이로 인한 시장의 유동성 공급으로 미국, 중국 등 글로벌 경제 대국 소비자들의 보복소비가 호황이 이어졌다.

하지만 이러한 보복소비 트렌드는 엔데믹이 시작되면서 사라지기 시작했다. 컨설팅기업 베인앤드컴퍼니에 따르면 글로벌 명품 시장의 2023년도 매출은 3,620억 유로(약 536조원)로 전년 대비 3.7% 증가했다. 2021년과 2022년 성장률이 각각 전년 대비 31.8%, 20.3%를 기록한 것과 비교하면 성장세가 둔화했다. 전문가들은 올해부터 본격적으로 명품 시장에도 저성장 기조가 확산하면서 소비 시장 역시 크게 위축될 것으로 전망한다.

지난해까지 글로벌 명품 시장의 성장세를 견인했던 중국의 소비 시장도 상황이 개선될 기미가 보이지 않는다. 부동산을 기반으로 한 경제 성장이 한계에 봉착하면서 기업의 연쇄 도산 우려가 커지고 있는 데다 기업의 부진으로 청년 실업률도 급증하고 있기 때문이다. 명품시장의 '큰 손'으로 떠오르던 2030세대의 소비력마저 감소하면서 광군제 매출 수치도 2년 연속 줄어들었다. 여기에 맥킨지 등 여러 기관들이 중국의 소비자 지출 증가율이 더욱 둔화할 것으로 전망하면서 글로벌 명품 업계의 위기감이 본격화되고 있는 모습이다.

쿠팡, 공정위 결정 두고 이례적 '장외 공방'

美 증권거래위에 ‘한국 공정위 부당함’ 공시

'전국 100% 로켓배송' 계획 철회 등 초강수

쿠팡이 업계 최대 과징금을 부과한 공정거래위원회의 조처를 두고 연일 반박 자료를 내놓으며 공방을 이어가고 있다. 최근에는 미국 증권거래위원회(SEC)에 '한국 공정거래위원회가 전 세계 모든 온라인쇼핑몰이 따르는 관행(practice)을 법 위반으로 결론 내렸다'고 공시했다. 겉으로는 쿠팡의 모회사인 쿠팡Inc가 뉴욕증권거래소에 상장돼 있어 미국 주주들에게 쿠팡의 입장과 대응 계획을 밝힌 것이지만 속내는 공정위의 판단이 부당함을 알리기 위한 조치로 풀이된다.

16일(현지시각) SEC에 따르면 쿠팡은 지난 14일 "한국 공정위가 쿠팡의 검색 순위를 기만적인 행위로 정의하고 법을 위반했다는 결정을 내렸다"고 공시했다. 그러면서 "검색 순위는 한국을 비롯해 전 세계 모든 온라인 쇼핑몰이 따르는 관행"이라며 "법정에서 공정위 조처를 놓고 치열하게 다툴 것"이라고 강조했다. 공정위가 모든 쇼핑몰이 하는 관행에 대해 위법이라는 판단을 내렸다는 취지로 읽힌다.

앞서 지난 13일 공정위는 "쿠팡이 검색 알고리즘을 조작하고 임직원을 동원해 자체브랜드(PB) 등 자사 상품을 쇼핑몰 검색 상단에 배치한 행위는 기만적인 고객 유인행위에 해당한다"며 유통업계 최고액인 1,400억원의 과징금을 부과하고 쿠팡을 검찰에 고발했다.

이에 쿠팡은 공정위의 결정에 불복 방침을 밝히며 행정 소송을 예고, 공방을 이어가고 있다. 17일 쿠팡은 보도자료를 통해 "고물가 시대에 PB 상품은 유통업체 중요한 차별화 전략"이라며 "모든 유통업체는 각자의 PB 상품을 우선으로 추천 진열하고 있다"고 반박했다. 그러면서 "소비자들은 오프라인 유통업체가 PB 상품을 눈에 가장 잘 보이는 골든존에 우선 진열하는 것처럼 온라인 유통업체의 PB 상품 추천도 당연하게 인식하고 있다"며 온오프라인 유통업체의 PB 상품 노출 사진을 공개했다.

쿠팡은 또 "소비자들은 PB 상품이 우선 노출됐다고 무조건 구매하지 않고 같은 쇼핑몰은 물론 다른 온라인몰과 가격비교 사이트까지 검색하는 등 제품 가격을 꼼꼼히 비교해 합리적인 선택을 하고 있다"며 "쿠팡 PB 상품 매출 비중이 5%에 불과하다는 것이 이를 입증한다"고 강조했다. 이어 "유통업체는 차별화된 상품으로 경쟁해야 하는데 디스플레이 전략까지 일률적 기준을 따르라고 강제한다면 기업 간 경쟁은 위축되고 소비자 편익은 줄어들 것"이라고 주장했다.

하지만 공정위는 오프라인 유통업체와 다르지 않다는 쿠팡의 주장에 대해 '이중적 지위'를 근거로 제시했다. 쿠팡은 검색 순위 산정 기준을 정하고 상품거래를 중개하는 플랫폼인 동시에 자사의 상품을 판매하기 때문에 이해충돌이 발생할 수 있는 위치에 있다는 것이다. 오프라인 매대 진열과 온라인 검색 순위 노출은 다르다는 점도 강조했다. 오프라인 매장은 소비자가 매장 전반을 둘러보고 상품을 구매하는 반면, 온라인에서는 검색 순위 20위 내에서 대부분의 상품 판매가 이뤄진다는 지적이다.

임직원 후기도 소비자의 선호와 무관하게 이뤄졌다고 판단했다. 일례로 한 PB 상품에 대한 임직원 3명의 구매 후기 평균 별점은 4.3점이었는데, 이후 일반 소비자 10명이 준 평균 별점은 2.8점으로 뚝 떨어졌다. 아울러 이커머스 업계의 관행이라는 주장에 대해서는 유럽연합(EU) 경쟁 당국이 아마존이 자사 제품을 우선 노출한 행위를 제재한 사례를 들며 해외 경쟁 당국도 온라인 플랫폼 사업자의 상품 노출 관련한 불공정 행위를 제재하고 있다고 했다.

반면 쿠팡은 공정위가 이커머스의 불공정 행위를 판단하는 기준이 명확하지 않다는 입장이다. 앞서 지난 2021년 공정위는 쿠팡이 LG생활건강 등 101개 납품업체를 상대로 할인 비용을 전가하는 등 '갑질'을 했다며 시정명령과 함께 과징금 약 33억원을 부과한 바 있다. 쿠팡은 이에 불복해 소송을 제기했고 올해 2월 서울고법은 시정명령과 과징금을 모두 취소하라며 원고 승소 판결했다. 당시 재판부는 "거래 당사자 사이에 거래 조건에 관해 여러 가지 사항을 요청·교섭·협의하는 것이 당연하다"며 "쿠팡 행위가 정상적인 거래 관행을 벗어났다고 인정하기 어렵다"고 판시했다.

쿠팡과 공정위 간의 공방이 이어지는 가운데 쿠팡은 20일 개최 예정이던 부산 첨단물류센터 기공식을 전격 취소했다. 이어 '전 국민 100% 무료배송'을 위한 3조원 물류 투자와 상품 구매를 위한 22조원 규모의 국내 투자도 중단을 시사했다. 올해 착공 예정이던 이천·김천·제천 물류센터 건립 일정도 무기한 보류하는 분위기다. 앞서 쿠팡은 지난 3월 오는 2027년까지 전 국민이 무료 로켓배송 서비스를 받을 수 있도록 총 3조원 규모의 물류센터 건립 계획을 발표한 바 있다.

쿠팡은 "다른 전자상거래 플랫폼과 달리 매년 수십조 원을 들여 로켓배송 상품을 직접 구매해 빠르게 배송하고 무료 반품까지 보장해 왔다"며 "로켓배송 상품을 자유롭게 추천하고 판매할 수 없다면 모든 재고를 부담하는 쿠팡으로서는 더 이상 지금 같은 로켓배송 서비스를 유지하기 어렵다"고 주장했다. 공정위와의 분쟁이 해결돼 관련한 불확실성이 해소될 때까지 신규 물류센터 투자를 중단하겠다는 의미로 해석된다.

쿠팡은 공정위의 이번 제재로 자사가 보유한 직매입·PB 상품 우선 노출 관행이 타격을 입으면 그동안 회사 성장을 견인한 로켓배송의 경쟁력이 크게 훼손될 것으로 우려한다. 공정위에 따르면 지난해 쿠팡에서 판매하는 직매입 상품 수는 600만개, PB 상품 수는 1만5,000여 개에 달한다. 지난해 31조원대 매출을 거둔 쿠팡은 전체 매출 중 90%가 직매입이고, 나머지 10%가 오픈마켓 관련 매출로 알려져 있다.

일각에서는 쿠팡의 강경 대응을 두고 '아시아의 아마존'을 표방하며 글로벌 사업을 확장하는 상황에서 공정위 제재가 걸림돌이 돼서는 안 된다는 위기의식이 작용한 것으로 보고 있다. 실제로 최근 미국, 일본, 유럽 등에서 크고 작은 악재가 이어지고 있다. 지난해 쿠팡은 일본 진출 2년 만에 시범 서비스를 종료하고 현지 이커머스 사업에서 철수했다. 온라인 채널의 침투율이 낮은 데다 현지 1위 플랫폼 아마존 재팬이 이미 당일배송, 수령일 지정 서비스 등 배송 관련한 특화 서비스를 제공하고 있기 때문이다.

미국에서는 주주대표소송이 진행 중이다. 2021년 뉴욕 증시에 상장한 쿠팡 lnc는 1년 만에 주가가 10달러 밑으로 주저앉았고 이후 지금까지 20달러를 넘지 못하고 있다. 상장 당일 장중 기록한 최고가 69달러와 비교하면 70% 넘게 하락한 수치다. 이에 한인 투자자와 뉴욕시공무원연금 등 주주들은 "기업공개 신고서에 허위 또는 사실을 오인할 내용을 담았고, 상장 이후 불공정 행위로 인한 주가 폭락 손실을 보상하라"며 소송을 제기했다. 원고 측은 소송을 제기한 이유 중 하나로 쿠팡의 알고리즘 조작 혐의에 대한 공정위 조사를 언급했다. 2022년 제기된 해당 소송은 올해 3월부터 미 뉴욕남부연방법원이 유사한 건을 병합해 진행하고 있다.

파페치(Farfetch) 인수와 관련한 소송전도 확대 조짐을 보인다. 지난 12월 쿠팡은 세계 1위 명품 이커머스 플랫폼 기업 파페치를 인수했지만, 쿠팡 인수에 불만을 품은 투자자들이 집단행동에 나섰다. 파페치가 지난해 3월부터 8월까지 주주를 상대로 기업 실적 등을 호도해 피해를 줬다는 것이다. 파페치가 쿠팡 인수 과정에서 주식 상장을 철회하기로 한 점에 대해서도 주주들의 소송이 늘어날 가능성이 있다. 여기에 파페치와 돈독한 유대관계를 보였던 유력 파트너마저 하나둘씩 파페치에서 손을 빼기 시작했다. 알려진 바에 따르면 케어링, 리치몬트, 니먼 마커스 등 명품 기업들이 계약을 해지하거나 중단하는 등 파페치와 결별 절차를 밟았다.

과학자 출신 대통령, 과학계 기대와 우려 속 출범

5명의 과학자 출신 지도자 사례 분석 통해 전망 제시

과학적 전문성과 소통 리더십 균형이 성공의 핵심

[해외DS]는 해외 유수의 데이터 사이언스 전문지들에서 전하는 업계 전문가들의 의견을 담았습니다. 글로벌AI협회(GIAI)에서 번역본에 대해 콘텐츠 제휴가 진행 중입니다.

멕시코 역사상 최초의 여성 대통령으로 선출된 클라우디아 셰인바움 파르도(Claudia Sheinbaum Pardo)는 물리학과 환경공학을 전공한 과학자 출신 정치인이다. 그녀의 당선은 과학계에 기대와 우려를 동시에 불러일으키고 있다. 셰인바움 대통령이 과학적 배경을 바탕으로 증거 기반 정책을 펼칠 것이라는 기대와 함께, 그녀의 멘토이자 전임 대통령인 안드레스 마누엘 로페스 오브라도르의 과학계와의 불편한 관계가 지속될 수 있다는 우려도 존재하는 것이다.

이러한 상황에서 과학 국제학술지 네이처는 과거 과학자 출신 세계 지도자 5명의 사례를 분석해 셰인바움 대통령의 향후 행보를 전망했다. 역사학자, 정책 전문가, 과학자들에 따르면 과학적 전문성이 국가 발전에 기여할 수 있지만, 자칫 독선적인 정책 결정으로 이어질 수 있다고 한다. 도쿄대학교 과학사학자 오키 사야카는 과학자 출신 지도자는 다양한 정보를 수집하고 분석하는 능력이 뛰어나지만, 자신의 지성에 지나치게 의존하여 독선에 빠질 수 있다고 지적했다.

허버트 후버(Herbert Hoover) 전 미국 대통령은 스탠퍼드 대학교에서 지질학을 전공한 후 국제적인 광산 컨설턴트로 성공하며 과학적 지식을 바탕으로 한 뛰어난 실력을 입증했다. 제1차 세계 대전 당시에는 벨기에 구호 활동과 미국의 식량 공급 관리를 통해 유능한 기술관료로서의 명성을 얻었다. 이후 상무장관을 거쳐 대통령에 당선되며 승승장구했다.

하지만 그의 기술관료주의적 성향은 대공황이라는 위기에 직면했을 때 한계를 드러냈다. 과학사 연구소 데이빗 콜(David Cole) 소장은 후버가 기술적인 해결책에 집중한 나머지 사회, 문화, 정치적 문제를 간과했을 가능성을 지적한다. 실제로 후버 정부는 불황 극복을 위한 다양한 정책을 시도했지만, 대중의 지지를 얻지 못하고 실패했다.

후버의 사례는 과학자 출신 지도자가 가진 장점과 단점을 동시에 보여준다. 전문 지식과 합리적인 사고는 국가 발전에 기여할 수 있지만, 사회 전체를 아우르는 통찰력과 소통 능력이 부족할 경우 위기 상황에서 효과적인 리더십을 발휘하기 어렵다는 점을 시사한다.

마거릿 대처(Margaret Thatcher) 전 영국 총리는 옥스퍼드 대학교에서 화학을 전공하고 노벨상 수상 화학자 도로시 호지킨의 지도로 항생제 연구를 수행한 과학자다. 하지만 그녀는 연구를 뒤로하고 정치에 뛰어들어 1979년 영국 최초의 여성 총리에 올랐다.

11년간의 재임 동안 대처는 강력한 리더십과 단호한 정책 추진으로 '철의 여인'이라는 별명을 얻었다. 국유 산업 민영화, 공공 지출 삭감 등 그녀의 정책은 영국 경제에 큰 변화를 불러왔지만, 동시에 빈부 격차 심화와 사회 갈등을 일으키기도 했다.

존 뮬바우어(John Muellbauer) 영국 옥스퍼드대 경제학자는 대처가 과학적 배경에도 불구하고 정책 결정 과정에서 과학적 증거보다는 이념과 신념에 더 의존했다고 평가한다. 이는 과학자 출신 지도자가 가질 수 있는 장점을 충분히 살리지 못한 아쉬운 부분으로 지적된다.

대처의 사례는 과학적 지식과 경험이 반드시 합리적이고 객관적인 정책 결정으로 이어지지는 않는다는 점을 보여준다. 지도자의 개인적인 신념과 가치관이 정책 방향에 큰 영향을 미칠 수 있으며, 이는 때로는 사회적 갈등과 불평등을 심화시킬 수 있다는 점을 시사한다.

압둘 칼람(A. P. J. Abdul Kalam) 전 인도 대통령은 인도 최초의 자체 개발 위성 발사체 성공을 이끈 항공우주 과학자로 국민적 영웅으로 떠올랐다. 이후 탄도 미사일 프로그램을 주도하며 '미사일 맨'이라는 별명을 얻었고, 2002년에는 여야의 지지를 받아 인도 11대 대통령에 당선됐다.

칼람은 대통령 재임 기간 동안 과학 기술 발전을 통한 국가 발전이라는 비전을 제시하며 젊은 과학자들에게 큰 영감을 줬다. 특히 식민 통치에서 벗어나 독립한 인도에서 과학 기술 자립을 통해 국가 발전을 이루겠다는 그의 의지는 과학계에 큰 자신감을 불어넣었다.

인도 과학 연구소의 로히니 고볼레(Rohini Godbole)는 칼람의 당선이 젊은 과학자들에게 희망을 줬으며, 인도 과학 시스템에 대한 믿음을 심어줬다고 평가했다. 칼람의 과학자로서의 업적과 대통령으로서의 리더십은 인도 과학 기술 발전의 중요한 원동력이 됐다.

양자 화학 박사 출신인 앙겔라 메르켈(Angela Merkel)은 2005년 독일 최초의 여성 총리로 선출되어 16년간 장기 집권하며 독일 역사상 두 번째로 오래 재임한 총리다.

메르켈은 유럽 부채 위기, 원자력 발전 단계적 폐지, 코로나19 팬데믹 등 다양한 문제에 직면했지만, 과학자로서 훈련된 실용주의적 접근 방식으로 문제 해결에 능숙하게 대처했다. 영국 코번트리대학교 정치학자 매트 큐보트럽(Matt Qvortrup)은 메르켈이 정치적 문제를 해결할 때 과학적 방법론을 적용하여 효과적인 해결책을 찾고, 반증 가능성을 열어두는 자세를 유지했다고 평가했다.

메르켈의 과학적 배경은 협력적인 문제 해결 능력을 키우는 데 기여했으며, 정치적 논쟁보다는 정책을 통한 문제 해결에 집중하는 리더십을 발휘하여 높은 국민적 지지를 얻었다. 그녀의 성공은 과학적 사고방식이 정치 분야에서도 효과적으로 활용될 수 있음을 보여줬다.

유키오 하토야마(Yukio Hatoyama) 전 일본 총리는 스탠퍼드 대학교에서 산업공학 박사 학위를 받고 연구원으로 활동한 과학자 출신이다. 하지만 그의 총리 재임 기간은 8개월이라는 짧은 기간에 그쳤다.

일본 도쿄대학교의 과학사학자인 사야카 오키(Sayaka Oki)는 하토야마가 과학자 특유의 이상주의적 성향 때문에 현실 정치의 벽을 넘지 못했다고 분석한다. 그는 순수하고 이론적인 사고에 집착하여 복잡한 정치 현실을 제대로 파악하지 못했다는 것이다.

하토야마는 2009년 총선에서 승리하며 과학 프로그램 지원 확대를 공약으로 내걸었지만, 실제로는 정부 지출 삭감을 추진하며 과학계의 반발을 샀다. 또한 오키나와 미군 기지 이전 문제에서도 현실적인 타협안을 선택하며 공약을 지키지 못해 지지층을 실망시켰다.

결국 하토야마는 '순진하고 세상 물정 모르는' 정치인이라는 비판 속에 8개월 만에 총리직에서 물러났다. 그의 실패는 과학적 지식과 이상주의만으로는 성공적인 정치를 이끌 수 없다는 교훈을 남겼다.

물론 셰인바움 대통령의 미래는 과거 과학자 출신 지도자들의 사례를 통해 완벽히 예측할 수는 없지만, 과학적 전문성과 포용적 리더십의 조화가 핵심임을 역사는 보여준다.

셰인바움 대통령이 과학적 지식을 바탕으로 합리적인 정책을 추진하면서도 다양한 의견을 경청하고 소통하는 균형 잡힌 리더십을 보여줄 수 있을지, 앞으로의 행보에 귀추가 주목된다.

*편집진: 영어 원문의 출처는 사이언티픽 아메리칸(Scientific American)으로 본지의 편집 방향과 일치하지 않을 수도 있습니다.